新HPCの歩み(第189回)-2002年(e)-

|

アメリカ政府のDOEがASCI計画を推進する一方、NSFはNCSA、SDSC、ANL、Caltechの4カ所を中心にTeraGridを構築しItanium 2により分散的テラスケール環境を実現する。SDSCはクラスタ/グリッド路線に転換する。DODはHPCS(高生産性コンピューティングシステム)を打ち出す。 |

アメリカ政府の動き

1) TeraGrid

前年のところに書いたように、米国NSFは、2001年8月、分散したテラスケール施設を目指して$53MをNCSA、SDSC、ANL、Caltechの4カ所に投じて分散的テラスケール環境DTF (Distributed Terascale Facility)を構築し、これを40 Gb/sの高速のネットワークで接続すると発表した。このTeraGridは、世界最強のコンピューティング・グリッドのプロジェクトである。全システムの納品をIBM社が担当し、内容はItanium 2 (McKinley)ベースのLinuxクラスタとストレージ製品である。光ファイバー・ネットワークは、 Qwest Communication 社から供給される。グリッドの基本ソフトとしてGlobusを参加研究機関で開発する。

2002年10月、NSFは3つの研究機関(NCSA, SDSC, PSC)に$35Mの資金を投入しTeraGridを拡張することにした。ANLとCalTechは上記3機関を通して資金を受け取る。これによりTeraGridはPSC (Pittsburgh Supercomputing Center)が加わってサイト数が5に増えた。前年の記事に書いたように、PSCはすでにNSFから$45Mを得て、TCS-1 (Terascale Computing System)と呼ばれるテラスケールシステムを構築していた。これらを合わせ、総計算能力は20 TFlops、ストレージは1 PBとなる。(HPCwire 2002/10/18) コンピューティングを担当するNSCAでは2002年4月、160台のdual Itanium IBM IntelliStationからなるマシンTitanの運用を開始した。(HPCwire 2002/4/19)

ANLとNCSAは20 Gb/sのネットワークでつながっているが、2002年秋の終わりまでに、Qwest Communications社は、シカゴのハブStarLightとロサンゼルスのハブをつなぐ40 Gb/sのバックボーンネットワークにより、イリノイ州のこの2カ所を、カリフォルニア州のSDSCとCalTechと結合する。PSCは30 Gb/s のネットワークにより、StarLightとつながる。

5機関の分担は以下の通り。

- NCSAは第2世代および第3世代のItaniumプロセッサを用いたLinuxクラスタにより、10 TFlops以上の計算資源を提供する。合わせて、230 TBのSANストレージを持つ。

- SDSCは500 TBのSANストレージを落ち、データサービスを担当する。現存のSunFire 15000に加えて、2台の32プロセッサPOWER4データベースサーバーを持つ。さらに、4 TFlopsのItaniumのLinuxクラスタと、1.1 TFlopsのPOWER4計算機も持つ。

- PSCは6 TFlopsのTCS-1システムと、0.3 TFlopsのHP Marvelシステムを持ち、512 GBのメモリを持つ強力な共有メモリ計算能力を提供する。合わせて、150 TBのディスクキャッシュを持つ。

- ANLはTeraGridの遠隔レンダリングと可視化の役割を担う。180ノードの可視化クラスタは、研究者に開放されている可視化クラスタとしては最大である。

- CalTechのCACRはSun Microsystems社のデータサーバにより、データ解析を行う。このシステムはミドルサイズのTeraGridサイトのプロトタイプとなる。

新しい機器は今後1年半以内に配備される。アメリカ中の研究者は Internet2やAbileneネットワークによりTeraGridにアクセスできる。

正式発表はなかったが、2002年11月、Itainum 2を800個以上搭載したIBM社のクラスタ(コード名Man-of-War)がNCSAに設置され動き始めた。最終的には3300個のItanium 2を搭載することになる。

2) NCSA (p690)

NCSA (National Center for Supercomputing Applications, University of Illinois)は、TeraGridとは別に、SGI社のOrigin 2000(1512プロセッサ)の更新として、IBM POWER4 p690スーパーコンピュータを設置する予定であると11月発表した。これはIBM社のeServer p690 UNIXシステム(32個の1.3 GHz POWER4を搭載)を12台GigEtherで結合したクラスタである。 (HPCwire 2002/11/8) このシステムは、2003年6月のTop500において、コア数384、Rmax=708.00 GFlops、Rpeak=1,996.80 GFlopsで、99位にランクしている。相互接続網をColonyに変えなかったようである。

3) SDSC(センター長交代、Rocks)

|

|

SDSC (San Diego Supercomputer Center)は、2001年2月にセンター長がSid KarinからFran Bermanに変わって体制も一新された。何人かの著名な人物が役職から離れたり、センターを去ったりした。Big iron路線からクラスタ/グリッド路線に転換したようである。MTA-1も撤去された。(HPCwire 2002/4/26)

SDSCを中心とするNPACIでは、2001年、Linux-baseのクラスタを構築するためのツールキットRocksを開発したが、6月にはRocks 2.2.1が公開され、Itaniumを搭載したLinuxクラスタも構築できるようになった。(HPCwire 2002/6/14)

4) Rice大学(RTC)

テキサス州HoustonのRice大学では、NSFから$1.15Mの資金を受け、RTC(Rice Terascale Cluster)を来年建設する。これはItanium 2を70基以上Myrinetで接続したもので、テキサス州初のTFlops級の資源となる。ただし70基では1 GHzとしても280 GFlopsで、TFlopsには遠い。(HPCwire 2002/8/9) 実際には、2003年6月のTop500において、コア数174、Rmax=487.20 GFlops、Rpeak=626.40 GFlopsで187位にランクしている。

5) CTC (Cornell Theory Center)

1997年、NSFのPACIプロジェクトに採択されなかったCTCは、1999年8月、500 MHzのIntel Pentium III Xeon 4個から構成されるDellのPowerEdge serversを64台接続したWindows NTクラスタを設置したことはすでに述べた。2002年8月、CTCは、Dell社、Intel社、 Microsoft社の協力により、HPCソリューションの開発設置で合意したと発表した。予算は、今後4年にわたり$60Mである。このシステムは、Dell社のPowerEdgeサーバを構成要素とし、プロセッサはIntel社のXeonとItanium、OSはMicrosoft社のサーバソフトウェアである。(HPCwire 2002/8/16) Linuxでないところが注目される。まず、16台のWindowsサーバをInfiniBandで接続したクラスタを作る。(HPCwire 2002/9/13)

2003年6月のTop500では、プロセッサはPentium 4 Xeon 2.4 GHz、コア数384、相互接続網はGigabit Ethernet、OSはWindows 2000、Rmax=1068.00 GFlops、Rpeak=1843.2 GFlopsで、49位にランクしている。2003年11月にはコア数を640に増やして、Rmax=1503.0 GFlops、Rpeak=3073.0 GFlopsで、68位となっている。Itaniumは使われていないようである。

6) LANL (ASCI Q)

2002年の完成を予定していたASCI Qの完成は遅れ、2003年完成予定となった。2000年のところに書いたように、DOEのNNSA (National Nuclear Security Administration)は2000年8月22日、ASCI Whiteの次の30 TFlops級のマシンASCI Q(LANLに設置)をCompaq社に発注したことを発表した。DEC Alpha EV68 (1.25 GHz) を32個搭載のAlphaServer GS320約375台をQuadricsのネットワークで結合したものを予定していた。CPU総数は12000個、総メモリは12 TB。当初は2002年に運用開始を予定していたが、登場したのは各10 TFlops(つまり1/3規模)のマシン2台だけで、全体の完成は2003年に遅れることになった。そのため不幸なことに地球シミュレータの後塵を拝してしまい、最初から2位であった。2003年6月にはこの2台が結合されてRpeak=20 TFlopsとなったが、フルスケールのRpeak=30 TFlopsのマシンは結局登場していない。しかも先にはASCI PurpleやBlueGene/Lが控えている。最も不運なASCI machineであった。

NY Times紙のGeorge Johnson記者によると、ASCI Qのわきには、冷蔵庫ほどの大きさのTransmetaクラスタが置かれているそうである。性能はわずか160 GFlopsだが、価格性能比は3倍よく、もちろん省エネルギーで、将来のスーパーコンピュータの姿を示している。(HPCwire 2002/6/28)

7) LANL (Linux cluster)

LANL (Los Alamos National Laboratory)は、2002年9月、2048プロセッサのLinuxクラスタをLinux NetworX社に発注したと発表した。このマシンは、研究所のミッションである核兵器の貯蔵管理のための将来のスーパーコンピュータのモデルである。(HPCwire 2002/9/27) このマシンは、2003年に設置された、2816個のOpteron 2 GHzをMyrinetで接続したLightningであろう。2003年11月のTop500で6位にランクしている。LANLはこの後もいくつかのクラスタをLinux Networx社から調達している。

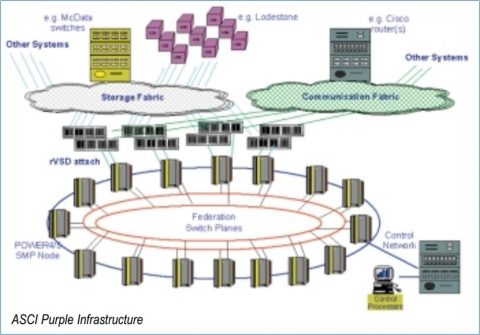

8) LLNL (ASCI Purple)

SC2002の最終日の2002年11月20日11時(MST)に、当初計画では最後のASCIであるASCI Purple(100 TFlops級)は、IBM社が受注し、LLNLに設置されることになったと発表があった(HPCwire 2002/11/19)。ASCI WhiteもBlueGene/LもLLNLに置かれる。ASCI Purpleは、12000個のPOWER5コアからなるSMPクラスタで、一つのSMPは64プロセッサで256コア、メモリは256GBとのことであった。システム全体は200個のSMPノードからなる。相互接続網のバンド幅はピーク64 GB/s。2004年12月までに設置を完了とのことであった。POWER5の技術情報が公開されたのは2003年のHot Chips会議であった。図は、SNLのレポート(現在リンク切れ)から。

|

9) LLNL (BlueGene/L)

LLNLのもう一つのスーパーコンピュータはBlueGene/Lである。2002年1月ごろの発表では、180/360 TFlops with 16 TBとのことであった。ピーク性能が2種類あるのは、プロセッサチップ上にある2つのCPU(コア)の両方を計算につかうか、片方を計算にもう一方を通信に使うかの違いであろう。BlueGeneの当初の計画では完全なPIM (Processor-in-Memory)で、1 PFlopsに対し500 GBしかなかったのと比べるとだいぶ現実的になった。180 TFlopsに対し16 TBというと、B/Flops比は0.09で、地球シミュレータの0.25(10 TB/40 TFlops)と比べてもそれほど遜色はない。しかも、実効性能のピーク性能に対する比はベクトルよりも悪いと考えれば、ほぼ同じレベルである。この背後に、Columbia大学の格子ゲージ専用コンピュータであるQCDSPやQCDOCのグループが協力して、設計に影響力を行使したという話もある。

10) LLNL (Evolocity)

|

|

LLNLとLinux Networx社は、世界最大のLinuxクラスタを2002年秋にLLNLに設置すると発表した。これはLinux NetworxのEvolocityクラスタで、2.4 GHzのIntel Xeonプロセッサ1920個をQuadrics社のネットワークで接続したものである。ピーク性能は9.2 TFlopsである。(HPCwire 2002/7/19)

実際にはプロセッサ数を増やし、2002年11月のTop500ではコア数2304、Rmax=5.694 TFlops、Rpeak=11.060 TFlopsで5位にランクしている。Linpack効率が51%で低いという感じだが、次の2003年11月のTop500では、コア数そのままでRmax=7.634 TFlopsに上げ、3位となっている。写真はLinux Networx社の講演スライドから。

11) SNL (ASC Red Storm)

米国Cray社とSNL (Sandia National Laboratory)は米国時間10月21日、AMD Opteron(後述)を用いた超並列スーパーコンピュータ“Red Storm”の納入について$90Mの複数年契約を結んだと発表した。AMD Opteronを搭載し、HyperTransportベースの3次元相互接続網で結合したシステムで、ピークは40 TFlops。これはASCI計画の一環として新たに計画されたもので、運用開始は2004会計年度の予定。(HPCwire 2002/10/25)(「日経コンピュータ」2002/10/22) Red Stormの背景については大原氏の記事(ASCII.jp 2015/2/23) に詳しい。

12) NERSC (Seaborg)

LBNLにあるNERSC (National Energy Research Scientific Computing Center)は2001年1月“Seaborg”という新しいスーパーコンピュータを隣町Oaklandの新しい拠点で構築を開始した。2002年11月8日、DOEはこれを増強し、プロセッサをPOWER3からPOWER3+に変え、その数を3328個から6656個に倍増させる契約を結んだことを発表した。2003年4月までにアップグレードを完了する予定。これでピーク性能は10 TFlopsとなる。NERSCの歴史上初めてCray社のコンピュータが存在しなくなるとのことである。(HPCwire 2002/11/8)

2003年6月のTop500では、Seaborgはコア数6656、Rmax=7304.00 GFlop、Rpeak=9984.00 GFlops、で5 位にランクしている。2008年1月7日引退。Phase Iと区別するために、Seaborg IIとも呼ばれる。(NERSC History of Systems)

13) PNNL

エネルギー省傘下のPNNL (Pacific Northwest National Laboratory、ワシントン州Richland)は4月、Hewlett-Packard社にピーク性能11.8 TFlopsのIntegrityシステムを発注したと発表した。Itanium 2 (1.5 GHz)プロセッサを1936個Quadricsネットワークで結合したものである。Linux OSで動く最大のスーパーコンピュータであり、Intel社のIA64を用いた最大のシステムである。(HPCwire 2002/4/29) 2003年8月に完成し、11月のTop500では、コア数1936、Rmax=8.633 TFlops、Rpeak=11.616 TFlopsで、5位にランクする。

14) HPCS (DARPA)

アメリカ国防省のDARPA (Defense Advanced Research Projects Agency 国防高等研究計画局)は、それまで実効性能よりピーク性能に重点が置かれていたことの反省の上に立って、2002年6月にHPCS (High Productivity Computing System、高生産性コンピューティングシステム)プロジェクトを開始した。国防および産業用に生産性の高いスーパーコンピュータを開発するプロジェクトで、ハードウェアのみならずソフトウェアをも対象とする。2010年までの9年間にわたる長期計画で、Phase I, II, IIIに分かれている。HPC Challenge benchmarkもこの中で生まれる(2003)。

Phase IではIBM、Cray、Sun、HP、SGIのベンダ5社が参加した。期間は1年。Cray社は$3.6Mの契約を結んだと発表した(HPCwire 2002/6/21)。

15) NAVOCEANO(SV1ex、p690)

アメリカ国防省のNAVOCEANO (The Naval Oceanographic Office、海軍海洋研究所)は、1月、Cray SV1exを導入すると発表した。プロセッサ数や価格は不明である。(Cnet News 2002/1/2)

また、6月20日には、IBM社のp690を37台Colonyで結合したシステムを設置した。2002年11月のTop500では、コア数1184、Rmax=3.160、Rpeak=6.1568 (TFlops)で11位にランクしている。

16) North Carolina Bio-Grid

IBM社は2つのグリッドプロジェクトに参加した。一つは、アメリカで最初のBio-Gridプロジェクトの一つであるNorth Carolina Bioinformatics Gridで、ライフサイエンス研究用に、計算、ストレージ、ネットワーク資源を提供する。IBM社とNCGBC(North Carolina Genomics and Bioinformatics Consortium)が開発する。NCGBCには、University of North Carolina System, Duke University, GlaxoSmithKline Inc., the Research Triangle Institute, SAS Institute, Biogen, the National Institute of Environmental Health Sciencesなど60もの大学、企業、バイオメディカル研究所が参加している。

17) Pennsylvania大学「乳がん グリッド」

IBM社が援助したもう一つのプロジェクトはUniversity of Pennsylvania(Pennsylvania State Universityではない)が主催した乳がんのためのグリッドである(InfoWorld誌2002年11月4日号)。 乳がん治療のための、高速レントゲンデータ検索、コンピュータによる診断補助、パターン認識、レントゲン経費の削減、訓練を目的としている。参加者は、ORNL、University of Pennsylvania、University of Chicago、University of North Carolina、sunnybrook and Women’s College Hospital (Toronto)である。NDMA (National Digital Mammogram Archive)は北米の病院をつなぎ、どこで取ったX線画像でも直ちに参照できるようにする。技術基盤はIBM社のGlobus Toolkitである。

18) アメリカの「地球シミュレータ」

2002年6月頃のNew York Times(閲覧には要登録)やZDnetなどの報道によると、アメリカに気象シミュレーション用のスーパーコンピュータが計画されている。予算は$224Mである。第1フェーズでは、44台の IBM eServer p690のクラスタをNOAAに設置し、ピークは7.3 TFlopsとのことである。契約は3年ごとに最大2回まで更新され、2009年に2回更新された暁には100 TFlopsを越える、という勇ましい話であった。2002年11月のTop500では、NOAAのNational Centers for Environmental Predictionには、2台のIBM pSeries 690 Turbo 1.3 GHzが、コア数704、Rmax=1.849 TFlops、Rpeak=3.6608 TFlopsで、24位tieにランクしている。その後、2004年11月のTop500では、1.7 GHz POWER4+を搭載した、2台のpSeries 655が、コア数1152、Rmax=4.379 TFlops、Rpeak=7.8336 TFlopsで35位tieにランクしている。その後も増強を続け、2009年11月には、4.7 GHzのPOWER6 2Cを搭載したPOWER 575が、コア数1408、Rmax=21.51 TFlops、Rpeak=26.47 TFlopsで、469位にランクしている。100 TFlopsには到達しなかった。

19) アメリカ司法省がDRAMメーカ2社を調査

Micron Technology社(ノルウェー)とSamsung Electronics社(韓国)は、DRAM市場において競争阻害行為に出たという疑いで、アメリカ司法省が両社に情報提供を求める大陪審の召喚状(subpoena サピーナ)を送ったことが明らかになった。Samsung社はDRAMの世界最大のメーカであり、Micron社は2番手に付けている。Samsung社は司法省から情報提供の召喚状を受け取ったことは認めたが、詳細の説明は拒否した。Micron社は、カリフォルニア北地区の連邦地方裁判所(U.S. District Court for the Northern District of California)から6月17日(月曜日)に召喚状を受け取ったと発表したが、「わが社はアメリカの反トラスト法に違反する事実があったとは考えていない」と述べた。(HPCwire 2002/6/21)(ITmedia 2002/6/20)

20) FTCがRambusを提訴

アメリカFTC(連邦取引委員会)は、6月、Rambus社を反トラスト法違反として提訴した。委員会は5:0で、同社が標準化団体に詐欺的な方法で圧力をかけ、自社が特許を出願している技術を規格として採用させようとした、という違反を認定していた。(HPCwire 2002/6/21)

その後、2004年4月に行政法判事により却下の仮決定がなされたが、原告側代理人であるFTC審議官がFTCに上訴し(わかりにくい)、FTCは当該仮決定を覆す決定を出す。2007年2月5日、FTCは排除措置を命じる審決を下したが、3月16日、Rambus社の執行停止の申し立てを一部認め、ロイヤリティの第三者預託を決める。最終的に、2008年8月27日、DC連邦巡回区控訴裁判所(日本の高裁に相当)は、FTCの提訴を退け(「知的財産権の不当な行使と競争法」)、2009年2月23日、連邦最高裁もFTCの主張を認めなかった(ITpro 2009/2/24)。

21) 輸出緩和

1月Bush大統領はアメリカの企業が高速計算機をロシア、中国、インド、中東諸国に輸出する規制を緩めた。この規制は冷戦時代に核兵器拡散を抑止するために定められていたものである。(HPCwire 2002/1/11) しかし8月、アメリカ議会は大統領府に対し、ロシア、中国、インド、中東諸国に高性能コンピュータの輸出する場合には、十分な評価をすべきであると釘を刺した。(HPCwire 2002/8/9)

22) FY2003 Blue Book

アメリカ政府はFY2003 Blue Book:”Strengthening National, Homeland, and Economic Security”を2002年8月に公開した。ちなみにアメリカの2003会計年度は2002年10月から始まる。ここでは、政府支援によるIT研究開発の最重要目的は「米国の国家、国土および経済の安全保障の強化」のためであり、NITRD 計画により開発された先進技術が国家、国民および経済の安全の確保にいかに貢献しているかが強調されている。ハイエンドコンピューティング関係(HEC)予算は全体の半分近く(44.8%)を占めており、当初よりNITRD 計画の中心的存在となっている。NSFのTeraGrid、DOEのSciDAC (Scientific Discovery through Advanced Computing)などが強調されている。

次はアジアやヨーロッパの動きと、世界の学界の動き。中国の聯想集団は聯想集団は、中国初の商用スーパーコンピュータDeepComp1800を発表する。ヨーロッパでは11のスーパーコンピュータセンターが集まりDEISAを結成する。「グリッドの定義」とは何か?Bell研究所論文捏造疑惑が持ち上がる。

|

|

|