エクサスケール革命

Tiffany Trader

ポストペタスケール時代は、はるかに高い並列性とアーキテクチャ的な複雑性を持ったシステムによって印付けられている。流れを変える革新的な変化に失敗すると、次の1000倍の性能の障壁は、これまで以上に高い障壁となるだろう。2014年アルゴンヌ国立研究所エクストリームスケール・コンピューティングにおけるトレーニングプログラム(ATPESC)が8月に開催され、Pete Beckman教授が、「エクサスケール・アーキテクチャ・トレンド」と計算科学およびエンジニアリング・アプリケーションのプログラミングと実行における影響について講演を行った。

現在はユニークな時点にある、とエクサスケールテクノロジー・コンピューティング研究所のディレクターであるBeckmanは語っている。完全に将来保証されたコードを提供することはできないが、最高の実行をプログラムすることに影響する傾向がある。

現在のHPCの状態になる時には、Beckmanは2004年までに遡ることができる3つの主要トレンドを説明するノートルダムのPeter Koggeの図を示している。

- 電力の限界

- クロックの限界

- ソケットとコアの拡大

Koggeが示すように、2004年には根本的な変化があった。コンピューティングは、チップをこれ以上熱くできない、クロックの拡張は停止し、無償で性能が上がることは無くなる所まで行き着いたのだ。

「今やアプリケーションにおける並列度はすべての世代において劇的に増加しています。」とBeckmanは語っている。「私たちが次のような問題を持っています。これ以上パッケージ毎の電力を上げるようなことはできませんし、すでにクロックの限界に達していて、今や並列度を上げることでスケールさせています。そして電力問題がこの中心にあり、メモリなどのすべての種類の問題に転嫁されているのです。」

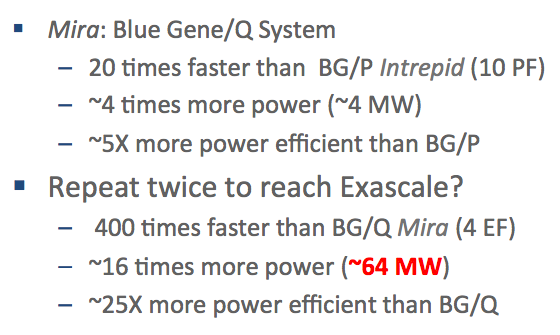

電力の問題を説明するために、BeckmanはIBM Blue Gene/Qシステムと、その先代であるBlue Gene/Pシステムを比較している。Blue Gene/Qは約20倍高速で4倍の電力を必要とするので、電力効率は5倍良くなっている。これはとても良い進展に見える。しかし、さらなる推定をすると、この5倍の線上に構築されたエクサスケール・システムは64MWの電力を消費するであろうことは明らかである。さらに展望を加えると、MWのコストが年間の電気代で百万ドル掛かるとすると、これは年間6千4百万ドルもの経費が掛かることになる。

Beckmanはこの問題の国際性を強調している。例えば、日本はエクサスケール・コンピューティング戦略において2020年という野心的な目標を設定しており、理化学研究所計算科学研究機構が主導している。まだ必要なすべての資金が確定している訳ではないが、プロジェクトのコストはおおよそ13億ドルと見積もられている。

世界中のリージョンは、エクサスケールの最終ラインはこれまでの1000倍の努力とは異なり、国際的協調が必要であると結論付けている。Beckmanは、TOP500リストの停滞がこの挑戦の難しさを表していると指摘している。これを踏まえ、日本と米国はHPCシステム・ソフトウェア開発における協力に関する協定を締結した。ISCで締結されたこの協定には重要な共同研究が含まれている。

ヨーロッパも同様に米国と日本との似たような協定を追い求めている。Horizon 2020プログラムの一環として、ヨーロッパは次世代システムの資金として2014年から2020年の間に7億ユーロの投資を計画している。このイニシアティブの一部には、ヨーロッパ中心のHPCベンダーを確立するという特別な関心が含まれている。

過去3回TOP500リストのおける世界最高速のコンピュータであるTianhe-2を所有する中国を語ること無しにグローバルなエクサスケール・レースの話を終えることはできない。Tianhe-2の冷却装置を含めて24MWという電力は、そのサイズにおいてはエネルギー効率が高いが、経費の問題から常に電気が入っている訳ではない。

主にインテルを搭載したシステムであるTianhe-2は中国国防科学技術大学(NUDT)が開発したSPARC由来のCPU、高速インターコネクト、Linuxの改良であるオペレーティングシステムを含んだ

国産部品も入っている。中国はHPC技術に多額の投資を続けていく。Beckmanは、中国の次のマシンの一つは(恐らくTOP10以内)、完全に自国の技術で構成されると予測していると語っている。

指数関数的な進歩は継続できるだろうか?

スーパーコンピューティング・チャートの古典的歴史を見ると、その巨大な電力が許容されている限り、システムは継続して性能をマークし続けるように見えている。デバイスレベルにおいては、基本的な限界に近づいている主要サイズに関するストレスがある。「なんらかの革命が無ければ、64MWスーパーコンピュータに向かっている曲線から我々は本当に脱することはできないのです。」とBeckmanは語る。「チップの数にしても、各チップの総消費電力にしても、すべては電力なのです。」

Beckmanは、メモリ、スレッド、メッセージング、回復性および電力を含むソフトウェアに関しては変化の力をあげている。プログラミングモデルとOSインタフェースのレベルにおいて、Beckmanはコヒーレンスアイランドならびに持続性の必要性を提言している。

並列度の増加に伴い、同一の仕事は同一の時間であるという考え方は消え去っており、変動性(ノイズ、ジッタ)が新しい基準だ。「アーキテクチャは、コンポーネントやアルゴリズム、そして将来対処するタスクかスレッドかというアプローチの間でさらに変動性を示し始めることになります。」とBeckmanは聴衆に話した。「そしてエクサスケールに向かうにつれて、この機能を良く習得できるプログラマーはうまく行くことになるでしょう。」

次の世代のHPCユーザを誘致したりトレーニングすることはアルゴンヌ国立研究所のような主要なHPCセンターにとっては最優先事項だ。アルゴンヌがこの課題に取り組むひとつの方法は、エクストリームスケール・コンピューティングにおける集中サマースクールを開催することだ。1980年代に遡るこのサマープログラムを見ると、プレゼンテーションは目的とする聴衆(主に博士課程の学生およびポスドク)のみだけでなく、それが何処から来て何処に行くのか、HPCの状況に強い関心がある人にも価値がある。