AMD、Nvidia H100に匹敵するGPUを発表

Agam Shah オリジナル記事

もしあなたが、Nvidiaの自慢のH100 GPUをクラウドや既製品で見つける幸運に恵まれていないなら、AMDは検討する価値のある対抗馬を待機させている。

AMDは、AIや科学的コンピューティングをターゲットとした新しいGPU「MI300X」を発表した。このGPUはAIコンピューティングの大規模な需要により供給が不足しているNvidiaのH100の代替品として位置づけられている。

|

|

| MI300Xシリコンを披露するAMDのリサ・スーCEO | |

AMDのリサ・スー最高経営責任者(CEO)は、新しい第4世代Epyc CPUを含むデータセンター向け新製品を発表するライブストリーミング・プレゼンテーションで、「ところで、私はこのチップが大好きです」と語った。

AMDは次の四半期にMI300Xをサンプル出荷する予定だ。このGPUは第4四半期に生産が開始される予定だ。

MI300Xは、先に発表されたCPUとGPUを搭載したスーパーコンピューティング・チップMI300AのGPUのみのバージョンである。MI300Aは、来年ロスアラモス国立研究所に導入されるスーパーコンピューター「El Capitan」に搭載される。El Capitanの性能は2エクサフロップスを超えると予想されている。

しかし確かに、NvidiaのH100はデータセンターで確固たる地位を築いており、AMDがこれを克服するのは難しいかもしれない。グーグル・クラウドは先月、2万6000基以上のNvidia H100 GPUを搭載したスーパーコンピューター「A3」を発表し、マイクロソフトは検索エンジンに組み込んだAIサービス「BingGPT」の実行にNvidia GPUを使用している。オラクルとアマゾンもクラウドサービスを通じてH100 GPUを提供している。火曜日時点のNvidiaの時価総額は約1兆ドルで、AI GPUの需要に大きく後押しされている。

MI300Xのトランジスタ数は1,530億個で、5ナノメートルプロセスと6ナノメートルプロセスで製造された12個のチップレットが組み合わされている。AMDはMI300Aの3つのZen4 CPUチップレットを2つのCDNA-3 GPUチップレットに置き換え、GPUのみのMI300Xを開発した。

|

| ソース: AMDライブストリーム、2023年6月13日 |

「MI300Xでは、大規模な言語モデルのより大きなメモリー要件に対応するため、64ギガバイトのHBM3メモリーを追加しました」とスー氏は述べている。

MI300Xは192GBのHBM3メモリを搭載しており、スー氏によれば、これはNvidiaのH100の2.4倍のメモリ密度だという。H100のSXMおよびPCIeバージョンは、80GBのHBM3メモリを搭載している。

スー氏によると、MI300Xは5.2TBpsのメモリ帯域幅を提供し、これはNvidiaのH100 GPUより1.6倍優れていると主張した。この比較は、メモリ帯域幅が3.35TBpsのSXM版H100 GPUとの比較である。

しかし、Nvidiaには、NVLinkブリッジを介して2つのGPUをリンクするNVLバージョンのH100があり、これは合計188GBのHBM3メモリを搭載しており、MI300Xのメモリ容量に近い。また、帯域幅は7.8TBpsである。

スー氏は性能結果を抜き出して説明したが、重要なベンチマークである浮動小数点演算や整数演算の総合的な性能結果については語らなかった。AMDの担当者は性能ベンチマークを提供しなかった。

しかしスー氏によれば、CPUとGPUを搭載したMI300Aは、Frontierのスーパーコンピューターに搭載されているGPUのみのチップであるMI250Xアクセラレーターに比べて、8倍高速で5倍効率的だという。

AMDは、AIモデルをメモリ上で実行するために、より多くのメモリと帯域幅を詰め込んだ。AIモデルは通常、モデルの変更に伴ってストレージとメモリの間でデータを行き来させる際に、パフォーマンス上のペナルティを支払うことになる。

「大規模なモデルをメモリ上で直接実行できるため、大規模な言語モデルに対して優位性があります。その結果、大規模なモデルの場合、必要なGPUの数を減らすことができ、特に推論のパフォーマンスが大幅に向上し、総所有コストも削減できます」とスー氏は語った。

このGPUは、インフラに最小限の変更を加えるだけで、既製のハードウェアを使用して標準的なラック全体に展開することができる。NvidiaのH100は標準的なサーバーに導入可能だが、同社はAI GPUとGrace Hopper GPU、BlueFieldデータ処理ユニット、NVLinkインターコネクトなど他のNvidiaテクノロジーを組み合わせた特殊なAIボックスを推進している。

AMDの新しいGPUのショーケースは、AMD Infinity Architecture Platformと呼ばれるAIトレーニングおよび推論サーバーで、8基のMI300Xアクセラレーターと1.5TBのHBM3メモリーを搭載している。このサーバーはオープン・コンピュート・プロジェクトの仕様に基づいているため、標準的なサーバー・インフラに簡単に導入できる。

AMDのインフィニティ・アーキテクチャー・プラットフォームは、H100 GPUを8基搭載し、GPUメモリは640GB、システム全体で2TBのメモリを搭載しているNvidiaのDGX H100に似ている。Nvidiaのシステムは、32ペタフロップスのFP8性能を提供する。

データセンターのAI市場は、AMDにとって大きなチャンスだとスーは言う。今年の市場規模は約300億ドルで、2027年には1500億ドルに成長するという。

「というのも、とてつもなく大きな需要があるからです」とスー氏は言う。

Nvidiaは、CUDA開発スタックとAI Enterpriseスイートにより、AIツールの開発と展開を支援し、ソフトウェアではAMDに対して大きな優位性を持っている。AMDの幹部は、ソフトウェア開発ツールへの対応に多くの時間を費やし、CUDAを使ったNvidiaの独自モデルとは対照的に、オープンソースのアプローチに重点を置いていると述べた。

CUDAと同様、AMDのROCmソフトウェア・フレームワークは、もともとハイパフォーマンス・コンピューティング用に設計されたものだが、現在では、AIモデルの開発と実行およびチューニングに必要なライブラリ、ランタイム、コンパイラ、その他のツールをAI用に適応させている。ROCmは、オープンなAIフレームワーク、モデル、ツールをサポートしている。

AIサービスプロバイダーであるHuggingFaceのCEO、クレム・デランゲ氏は、同社のリポジトリに追加されているAIモデルをInstinct GPUで動作するように最適化していると述べた。先週、約5,000の新しいモデルがHuggingFaceに追加されたが、HuggingfaceはこれらのモデルをすべてInstinct GPU用に最適化している。

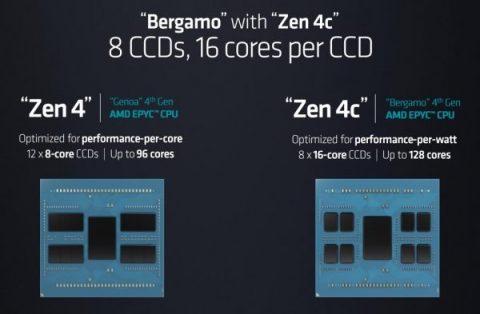

AMDはまた、クラウドコンピューティング用の初のチップファミリーとなるコードネーム「Bergamo」と呼ばれる第4世代Epyc 97X4 CPUの新ラインナップを含む新CPUも発表した。

|

| 第4世代のEpyc ソース:AMD |

Bergamoチップは、AmazonやAmpereが開発したArmベースのチップと比較することができる。Armベースのチップは、データセンターに配備され、クラウドのリクエストに応える。このチップは、コードを分割して膨大な数のコアに分散させることで、アプリケーションをマイクロサービスとして実行する。

Bergamoチップは、Zen4cアーキテクチャに基づく最大128コアを搭載し、8つのコンピュート・チップレットに分割されている。最上位のEpyc 9754は128コア、256スレッドで、最大360Wの電力を消費する。このチップは256MBのL3キャッシュを搭載し、最大3.10GHzの周波数で動作する。中位の9754Sも同様の仕様だが、1コードにつき1スレッドしか実行できない。最終版のEpyc 9734は112コアで、1コアあたり2スレッド動作し、320Wの電力を消費する。

|

メタ社は、次世代大容量コンピューティング・プラットフォームとしてBergamoをデータセンターに導入する準備を進めている。

メタ社のインフラ担当副社長であるアレクシス・ブラック・ビョーリン氏は、ステージ上でのプレゼンテーションの中で、「Bergamoを使用することで、Milanの2.5倍という大幅な性能向上が見られます」と述べた。

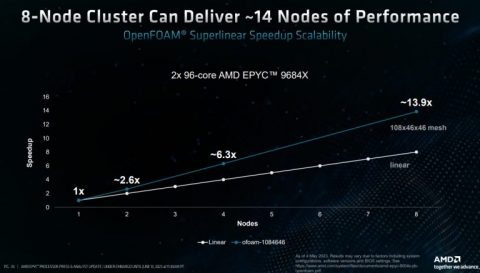

AMDはまた、コードネーム「第4世代Epycチップ Genoa-X」と呼ばれる、3D V-Cacheテクノロジーを搭載し、最大96個のCPUコアを採用したチップも発表した。このチップは第3四半期に発売される予定だ。

Genoa-Xのラインナップで最速のチップは9684Xで、96コア、192スレッドをサポートし、400ワットの電力を消費する。1.1GBのL3キャッシュを搭載し、最大3.7GHzの周波数で動作する。他の2つのSKU、9384Xと9184Xは、それぞれ32コアと16コア、768MBのL3キャッシュ、それぞれ3.9GHzと4.2GHzの周波数を持つ。チップの消費電力は320ワットである。

|

| ソース:AMD |