新HPCの歩み(第95回)-1990年(c)-

|

CERNのTim Berners-Leeは、1990年11月12日にWWWを提案したが、普及は数年後であった。アメリカでNSFが設立した5つのスーパーコンピュータセンターのうち、John von Neumann Supercomputer Centerが打ち切りになった。SLALOM benchmarkが提案された。 |

日米スーパーコンピュータ摩擦

1) 日米首脳会談

昨年のところで述べたように、1989年9月4日に日米構造協議(Structural Impediments Initiative、構造障壁イニシアチブ)が始まった。アメリカの対日赤字の原因を、日本の市場の閉鎖性にあるとして、経済構造の改革と市場の開放を迫った。1990年6月25日まで5回開催された。6月28日には最終報告が取りまとめられ、その進展状況を点検するために、1990年10月から1992年7月までに4回のフォローアップ会合が行われる。1993年からは日米包括経済協議。2021年公開された外交文書によると(朝日新聞デジタル2021年12月22日)、ブッシュ大統領(父)が1990年3月2日にカリフォルニア州Palm Springsに海部首相を招いて行われたTête-à-Tête(通訳のみ同伴のサシ)の会談で、ブッシュ大統領は海部首相に、保護主義の台頭を示唆して「両国間には不満が強まっており、自分の嫌悪する醜悪な動きがある」「自分は全力でこうした動きと闘っていくし、日本が構造協議で提起した米国が果たすべきことにも自分は取り組んでいく」と決意を述べたうえで、「友人であり、直前の選挙でより強固な指導者となった海部総理にも戦いに臨む自分を助けてほしい」として、「スーパーコンピュータ、半導体、りん産物(?)、衛星について総理の助力を必要としている」と、低姿勢で個別分野を挙げて助太刀を要請するスタンスをとったという。しかし、1991年のVP2600寄贈拒否事件、1992年の核融合科学研究所(土岐市)の調達に関する不服申し立て事件、豊田中央研究所の調達に関するクレーム事件など、スーパーコンピュータを巡る摩擦はなお続く。

2) 日本政府のスーパーコンピュータ導入手続き

1989年のところに書いたように、日本政府のアクションプログラム実行推進委員会は、1990年4月19日に「スーパーコンピュータ導入手続き」を改正し、300 MFlops以上の「スーパーコンピュータ」の政府調達に際しては、資料招請、仕様書の作成、官報公示を含む入札手続、技術審査、苦情処理などのやり方を定めた。その後スーパーコンピュータの定義は以下のように変わった。

|

政府調達におけるスーパーコンピュータの範囲 |

直前のTop500 Rmaxでの対応順位 |

|

|

1987年8月1日 |

100 MFlops以上 |

|

|

1990年5月1日 |

300 MFlops以上 |

|

|

1995年4月1日 |

5 GFlops以上 |

121位 |

|

1999年5月1日 |

50 GFlops以上 |

113位 |

|

2000年5月1日 |

100 GFlops以上 |

102位 |

|

2005年5月1日 |

1.5 TFlops以上 |

197位 |

|

2014年4月16日 |

50 TFlops以上 |

500位以下 |

|

2019年12月23日 |

2.0 PFlops以上 |

158位 |

|

2020年12月23日 |

2.4 PFlops以上 |

163位 |

|

2021年12月23日 |

2.88 PFlops以上 |

177位 |

(導入手続きの性能基準は、Rmaxとは書かれていないが、もしギリギリの数値のRmaxのコンピュータがあったら、Top500のどこに位置するかを参考までに記した。)

標準化

1) World Wide Web

CERNのTim Berners-Leeは、1990年11月12日に”WorldWideWeb: Proposal for a HyperText Project”を発表し、WWWを提案した。直ちに実装された。同じころ、archieと呼ばれる検索エンジン(1990年、McGill大学、ファイル名を検索)やGopherと呼ばれるテキストベースの検索システム(1991年、ミネソタ大学)などが開発されている。WWWやサーチエンジンの発展により事実上消滅した。筆者は、archieやgopherが前にあってWWWが提案されたのかと思っていたが、ほぼ同時のようである。

|

|

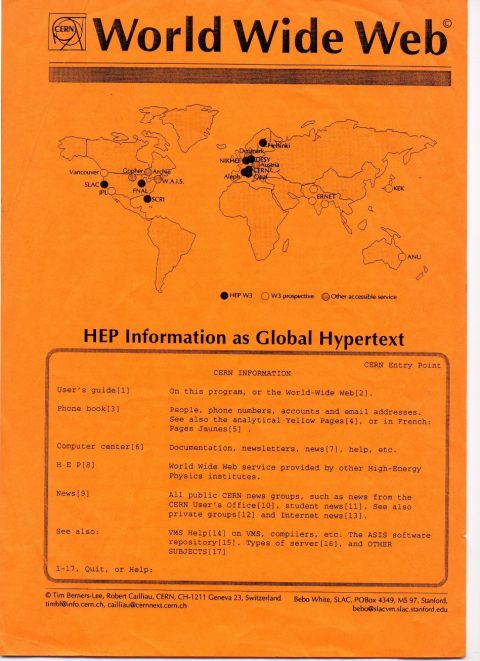

日本ではJCRNでインターネット管理組織をやっと考え始めたころ、世界ではインターネットを前提とした情報流通のシステムが始まっていたわけで、日本は全く出遅れていた。写真はCHEP92でTim Berners-Leeが配っていた高エネルギー物理学向けのWWWのパンフレット。KEKにもサイトがあることが示されている。

2) CORBA

1989年、OMG (Object Management Group)が、異機種にまたがる分散オブジェクト標準を策定するために11社(Hewlett-Packard、IBM、Sun Microsystems、Apple、American Airlines、Data Generalなど)によって設立されたが、1990年、最初のCORBA (Common Object Request Broker Architecture)が定義された。1991年にVer. 1.1、1995年にVer. 2.0が発行される。

3) Unix標準化断念

1980年代末からUnixの標準化に向けて、UI (Unix International)と、OSF (Open Software Foundation)とUSO (Unix Software Operation)の3者は話し合いを続けていたが、1990年4月、組織の統合を断念し、公式交渉を打ち切ったと発表した。UIの会員はAT&T、Sun Microsystems社、富士通、日本電気、東芝など。また、OSFは、IBM社、DEC社、HP社、日立製作所などで構成。1990年、OSF/1 1.0がリリースされた。

性能評価

1) SLALOM benchmark

アイオワ州AmesにあるDOEのAmes Laboratory(Iowa州立大学に運営委託、NASA Amesとは関係がない)のJohn Gustafson, Diane Rover, Stephen Elbert, Michael Carterは、1990年1月に“SLALOM The First Scalable Supercomputer Benchmark”を発表した。SLALOMとは、Scalable, Language-independent, Ames Laboratory, One-minute Measurementの省略であり、その名の通り、仕事を決めて時間を図るのではなく、時間を1分に定めて、その間にできる仕事の量で性能評価しようという考え方である。コンピュータの能力が向上すれば大きな仕事を与えるが、1分で済むところが味噌である。今の言葉でいえば、weak scalingで性能を評価するべきだとの主張である。筆頭著者のJohn Gustafsonが、1986年にオレゴン州のFloating Point Systems社にいたJohn Gustafsonだったとは当時気づかなかった。

SLALOMという名前は、スキー競技等で、ゲートで定められたコースを通って蛇行しながらゴールするまでの時間を競うslalom競技に掛けている。仕事としては、なぜか照明のラジオシティの計算(密行列連立一次方程式)を使った。

2) Gordon Bell賞

1990年のGordon-Bell賞は下記のとおり授与された。SCの会場でfinalistsが講演する形になるのは1992年からである。

|

Peak Performance |

|

Price-Performance |

|

Compiler Parallelization |

|

Honorable Mention: Eran Gabber, Amir Averbuch and Amiram Yihudai, Tel Aviv University; “Parallelizing Pascal Compiler,” 25x on a 25 node Sequent Symmetry |

国際的な動き

1) IPCC第1次評価報告書

1988年に発足したIPCC (Intergovernmental Panel on Climate Change)は、1988年11月にジュネーブにて開催された「IPCC第1回総会」にて報告書の作成を決定していた。その後、世界中の第一線の研究者が寄与した地球温暖化問題に関する研究成果についての評価を行い、それらの結果をまとめて第1次評価報告書(First Assessment Report 1990)を1990年発表した。この報告書は、「人為起源の温室効果ガスがこのまま大気中に排出され続ければ、生態系や人類に重大な影響をおよぼす気候変化が生じるおそれがある」という警告を発した。世界の第一線の研究者の手によるこの警告は、社会的に非常に注目され、後に、国連気候変動枠組条約(UNFCCC)の採択(1992年)および発効(1994年)を強力に後押しし、世界の地球温暖化防止政策の推進に多大な影響を及ぼすこととなる。当時のコンピュータの能力では、地球規模で長大な時間軸に及ぶ信頼できるシミュレーションによる解析はまだ困難であった。

なお、1992年には、第1次評価報告書をベースとして、その完成(1990年)以降の科学的知見を追加した「補足報告書」を発表する。

アメリカ政府関係の動き

1) ARPANET終了

NSFNetの拡大にともなってARPANETは縮小していったが、1990年2月28日、ARPANETが正式に退役した。またNSFNetは、バックボーンの通信速度を1.5 Mb/sから45 Mb/sに増強するとともに、ヨーロッパのネットワークとも接続を強化する。

2) CSCC結成

1990年11月、以下の機関により、CSCC (Concurrent Supercomputing Consortium)が結成された。

|

ARPA (Advanced Research Project Agency) |

|

ANL (Argonne National Laboratory) |

|

Caltech (California Institute of Technology) |

|

Center for Research on Parallel Computation |

|

Intel Corporation’s Scalable Systems Division |

|

JPL (Jet Propulsion Laboratory) |

|

NASA’s High-Performance Computing and Communications Program |

|

NASA’s Office of Space Science |

|

NSF (National Science Foundation |

|

Pacific Northwest Laboratory |

|

Purdue University |

このコンソーシアムは、分散メモリのMIMDコンピュータを推進し、その上のアプリケーションを開発するためのものである。具体的には、試作機であるが、IntelのTouchstone Delta Systemを購入し、コンソーシアムで共有することを決めた。実際には、1990年11月に、Intel iPSC/860 (64 node)をAjaxとして導入し、1991年5月にTouchstone Deltaを導入する。1993年6月の最初のTop500で、前者は204位、後者は8位にランクしている。

3) John von Neumann Supercomputer Center

1985年~86年にNSFが設立した5つのスーパーコンピュータセンターのうちPrincetonに設置されたJohn von Neumann Supercomputer Centerは、運営のまずさ、ETA10設置の遅れなどのため、NSFは1990年10月以降の第2期の予算を付けなかった。このためこのセンターは1990年4月に閉鎖された。

このセンターの設立は1986年で、最初数台のCyber 205を設置し、ETA10に置き換えていく予定であった。最初のETA10(液体窒素冷却?)は、1988年3月になって1年遅れで設置されたが、30時間に1回の割合でソフトウェア故障を起こし、また並列処理がほとんどできなかった。その後、数台の空冷のETA10も設置された。昨年のところに書いたように、ETA社は、残念ながら1989年4月に廃業してしまった。NSFはセンターに代替案を作際するため6ヶ月の猶予を与え、センターは4プロセッサのCray Y-MPを提案した。NSFの評価委員会は、センターが4プロセッサをフルの8プロセッサに増強する資金を自分で調達できるなら支援を継続すると決定していたが、センターを運営するコンソーシアムの理事会の同意を得られなかった。このため、NSFはセンターの閉鎖を決定し、その予算を他の4センターに配分した。

4) ヒトゲノム計画

アメリカでDOEとNIHが$3Bの予算でヒトゲノム計画を開始したのも1990年である。DOEとNIHは$3Bの予算を計上し、15年で完了することを計画していた。国際的には、英国、フランス、オーストラリア、日本などもコンソーシアムを作り参加した。国際的な協力の拡大と、配列解読技術、コンピュータ技術の大幅な進歩により、2000年にはdraft版が完成する。

他の国の政府関係の動き

1) 西ドイツ(SUPRENUM project)

西ドイツのSUPRENUM国家プロジェクト(1985年から)ではSupernum-1(256ノード)が稼働した。このプロジェクトはSuprenum-2に進むことなく1990年終了した。このころから、GMDはIntel i860を用いた次の並列計算機のプロジェクトMannaを計画していた。商用化のために設立したSUPRENUM Supercomputer GmbHは2010年7月12日業務を終了する。

2) Forschungszentrum Jülich

1967年に始まった西イツのKernforschungsanlage Jülich GmbH (Nuclear Research Centre Jülich)は、1990年、Forschungszentrum Jülich GmbH(Research Centre Jülich)に変わった。研究分野が広くなったか、あるいはすでに広かったので名前を合わせたのであろう。このセンターはRWTH Aachen University と緊密な協力関係にあった。センターのProfileによると、1987年に最初のスーパーコンピュータが稼働し、センターの機能を果たしていたそうである。Cray Research社の納入一覧(日本語)によると、1983年に、73番目の出荷として、「ドイツ原子力研究所」にCray X-MPを納入している。このころはKernforschungsanlage(KFA、原子核研究施設)と名乗っていたのでこれかもしれないが、確認が必要である。1993年、センターの中に正式にForschungszentrum Jülich(Jülich Supercomputing Centre)ができる。

3) EPCC(イギリス)

1990年9月、Edinburgh大学は正式にEPCC(Edinburgh Parallel Computing Centre)を発足させた。1986年からはEdinburgh Concurrent Supercomputer Projectがあり、Meiko Computing Surface supercomputerを設置した。最初は40プロセッサであったが、1987年には最大400プロセッサまで増強した。Meiko CSはセンター発足後も利用された。1992年10月には、3台のSPARCをホストとし、380台のT800を搭載する構成に変更する。

1993年6月の第1回のTop500では、Thinking Machines社のCM-200/16kが、コア数(Weitek FPUの数)512、Rmax=2.4 GFlops、Rpeak=5.0 GFlopsで、86位tieにランクしている。

4) 台湾(中央気象局)

台湾中央気象局は、1983年に導入したCDC Cyber 205を、Cray Y-MP81/632およびY-MP2Eに更新した。Y-MP81は、第1回のTop500(1993年6月)において、コア数(プロセッサ数)6、Rmax=1.65 GFlops、Rpeak=2.00 GFlopsで178位にランクされている。

次回は国際会議の話題である。並列処理関係で一番古い国際会議ICPP 1990(19回目)では「大規模並列プロセッサはいったいいつになったら商品になるのか」というパネルが開かれた。シンガポールのICHEP 1990で、筆者はQCDPAXについて発表した。

|

|

|