生成AIは2029年までに世界の電力消費の1.5%を占める

Agam Shah オリジナル記事「Generative AI to Account for 1.5% of World’s Power Consumption by 2029」

生成AIは、アプリケーションを実行するために必要な膨大なハードウェア要件に対応するため、世界の消費電力の大部分を占めることになる。「AIチップは今後5年間の電力使用量の1.5%を占め、世界のエネルギーのかなりの部分を占めることになります」と、半導体調査会社TechInsightsは先月のリサーチノートで述べている。

TechInsightsは、2025年から2029年にかけての世界の電力消費量を153,000TWhとし、米国エネルギー情報局から入手した。

この調査会社は、AIアクセラレータが同時期に世界の電力を2318TWh消費し、世界の電力消費の1.5%に達すると推定した。

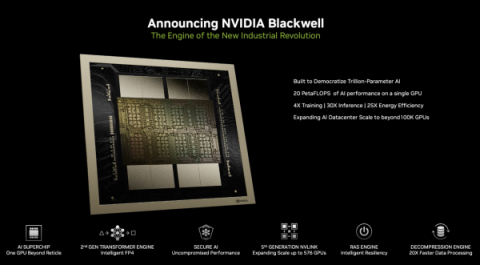

これはエヌビディアのフラッグシップGPUであるHopper GPUの消費電力で700Wで試算されている。ブラックウェルと呼ばれるエヌビディアの次期GPUはより高速だが、消費電力は1,200Wである。

TechInsightsの仮定には、チップが消費する電力のみが含まれており、生成AIに使用されるストレージ、メモリ、ネットワーク、その他のコンポーネントの消費電力は含まれていない。

TechInsightsのアナリストであるオーウェン・ロジャーズ氏は調査レポートの中で、「GPU容量に対する膨大な需要と、これらの高価な資産を汗水たらして回収する必要性を考慮すれば、このような高い稼働率は実現可能です」と述べている。

|

| 1200Wの電力を必要とするエヌビダ・ブラックウェルGPU(出典:エヌビディア) |

グリーンか否か?

マッキンゼーのAI調査によると、回答者の65%が生成AIを採用する意向を示している。

この需要に対応するため、クラウドプロバイダーやハイパースケーラは、GPU容量の増強に数十億ドルを投資している。 マイクロソフトはAIインフラを稼働させるためにエヌビディアのGPUに依存しており、メタは「約60万個のH100」GPUに相当する演算環境を保有することになる、と同社は述べている。

TechInsightsによると、エヌビディアは2022年の約260万GPUから、2023年にはおよそ376万GPUを出荷した。

ガートナーは昨年、AIが「世界の電力消費量の最大3.5%を消費する可能性がある」として、電力消費量についてより積極的な予測を示した。ガートナーの手法は明確ではないが、ネットワーク、ストレージ、メモリを含む可能性がある。

AI競争は、最速のインフラとより良い結果を提供する企業によって特徴づけられる。ビジネスにおけるAIの導入ラッシュは、長年確立されてきた企業の持続可能性計画を混乱させている。

マイクロソフト、グーグル、アマゾンは、より大規模なモデルを訓練し提供するために、GPUやAIチップを備えたメガデータセンターを建設するために数十億ドルを費やしているが、これは電力負担を増大させている。

コストの課題

サーバーは2万ドルで購入できるが、企業は増大する電力コストとエネルギーグリッドが直面する課題を考慮する必要がある、とロジャーズ氏はリサーチノートで述べている。

データセンターは、AIが必要とする電力を処理できるように設計する必要もある。その需要は、送電網の容量やバックアップ電源の有無に左右される可能性がある。

AI時代に備え、発電所、太陽光発電所、送電線などの電力インフラを整備する責任は、エネルギー供給者にもある。

「需要を満たすことができない場合、エネルギー供給会社は容量を拒否するのではなく、容量を管理するために市場ベースのアプローチ、つまり消費量を減らすために価格を引きあげることになるでしょう。繰り返しますが、これはAI技術のユーザーにとってコストに影響する可能性があります」とロジャーズ氏は言う。

米国政府の最初の目標は、2035年までに100%クリーンなエネルギーを発電することで、送電網の負担を軽減することだ。それはまた、より多くのAIデータセンターへの扉を開くことになるだろう。

エネルギーの生産的利用

AIが消費する電力は、暗号通貨マイニングが送電網に負担をかけているという初期の傾向を反映している。米国エネルギー情報局が2月に発表した報告書によると、暗号通貨マイニングは米国の電力消費量の約2.3%を占めている。

しかし、エネルギー業界のオブザーバーは、ビットコインのマイニングに比べ、AIの方がエネルギーの生産性が高いという意見で一致している。

エヌビディアのAIの焦点は、生産的なエネルギー使用にもある。消費電力を削減するため、エヌビディアのGPUには独自のチップ技術が盛り込まれている。同社はホッパーを空冷から液冷に切り替えている。

エヌビディアのハイパースケール・HPCコンピューティング事業担当バイスプレジデント兼ゼネラルマネージャーであるイアン・バック氏は、先月の投資家向けイベントで、「ここでのチャンスは…固定メガワットのデータセンターで最大のパフォーマンスを、可能な限り最高のコストで実現する手助けをすることです」と語った。

HPCプロバイダー、AI、持続可能性

先日のISC24スーパーコンピューティング会議のパネリストは、エヌビディアをからかい、同社の1000ワットGPUは 「持続可能 」だと主張した。

政府系研究所もまた、GPUと直接液体冷却は、過去のCPUよりも優れた性能スケーリングを提供すると述べている。

El Capitanと呼ばれる次期2エクサフロップ・スーパーコンピュータを構築しているローレンス・リバモア国立研究所は、冷却を28,000トンに増やし、さらに18,000トンを追加し、現在および将来のシステムの電源を85メガワットに引き上げた。

|

|

| LLNLのEl Capitan(出典:HPE) | |

「El Capitanは……40メガワット以下、約30メガワットになりますが、これは大量の電力です」と、LLNLの最高技術責任者(CTO)であるブロニス・デ・スピンスキー氏は分科会で述べた。

同氏は、El Capitanスーパーコンピュータが環境に優しいとは言えないかもしれないことを認めたが、その性能-電力エンベロープの中で達成される結果にも焦点を当てるべきである。例えば、スーパーコンピューターが使用するエネルギーは、気候問題を解決するのであれば、それなりの価値があるかもしれない。

「30メガワットのスーパーコンピューター?30メガワットのスーパーコンピューターが持続可能な資源だと言うつもりはありませんが、私たちが取り組みたい社会問題に対処するために多くのことができるかもしれません」とデ・スピンスキーは言う。

研究室も再生可能エネルギーや液体冷却に移行している。例えば、液冷は「冷却に必要なエネルギーの約50%を節約できる」とISC24のセッションでLRZのディーター・クランツルミュラー会長は述べた。

持続可能なコンピューティング環境では、カーボンオフセット、廃熱の回収と再利用、材料の再利用も検討されている。

HPCの過去が未来を動かす

スーパーコンピューターのエネルギー効率を高める取り組みは、現在、AI処理で消費されるすべてのワットを有効活用するために使われている。

先月のHPE Discoverカンファレンスで、アントニオ・ネリ最高経営責任者(CEO)は、FrontierとEl Capitanで使われているエネルギー効率化技術を、エヌビディアGPUを搭載したAIシステムに移植していると述べた。

「HPEは地球上で最大級の水冷製造能力を持っています。なぜか?スーパーコンピューターのために必要だからです」とネリ氏は語った。

同じく登壇したエヌビディアCEOのジェンセン・フアン氏は、「液冷の未来は、パフォーマンスの向上、インフラコストの低減、運用コストの低減など、あらゆることをもたらすだろう」と口にした。

AIのオフロード

コンシューマー機器メーカーは、オンデバイスAI用のニューラル・チップを搭載したPCやモバイル機器を売り込んでいる。ニューラル・チップはローカルでAIモデルを実行できるため、クラウド上のGPUへの負担が軽減される。

iPhoneやMacがAIタスクをデバイス上で実行できないと判断した場合、アップルのデータセンターにあるクラウドサーバーにクエリーを迂回させる。

アップルのユーザーは、AIをオンデバイスで実行するか、クラウド経由で実行するかを選択することもできる。

マイクロソフトは、ウィンドウズ・デバイスでのAIチップの使用を奨励している。クアルコムのAI Hubでは、ユーザーがベンチマークを実行し、AIモデルがデバイス上でどのように動作するかを確認できる。これによってユーザーは、推論をオンデバイスで実行するかクラウドで実行するかを決めることができる。

しかし、PCがクラウド上のGPUにAIのストレスをオフロードする具体的な例を提供するAI PC向けのキラーアプリケーションは存在しない。