AI時代のデータ活用:第1部 – エネルギーが究極のボトルネックとなる

オリジナル記事「Powering Data in the Age of AI: Part 1 – Energy as the Ultimate Bottleneck」

ここ数年、AIは現代において記憶に残るどの技術よりも急速に拡大してきた。かつて大学の研究室でひっそりと行われていたトレーニング処理は、今や高性能コンピューターが密集した巨大な施設に広がり、GPUのネットワークと膨大なデータを活用している。

AIは基本的に3つの要素で稼働する:チップ、データ、電力である。このうち、電力の拡張が最も困難な課題となっている。各新世代モデルはチップレベルでより強力かつ省電力化が図られているとされるが、総エネルギー消費量は増加の一途をたどっている。

大規模なデータセット、長期化するトレーニング、増加するパラメータが、従来システムでは不可能だった水準まで総電力消費を押し上げている。アルゴリズムの多様化は技術的障壁へと変貌した。AI発展の次なる段階は、計算能力ではなく電力供給を確保できるか否かにかかっている。

本シリーズ「AI時代のデータ活用」のこのパートでは、エネルギーが計算技術の進歩における決定的な制約要因となった経緯を考察する。トレーニングクラスターに供給するメガワット単位の電力から、それらを支える原子力プロジェクトや送電網の革新までを扱う。

エネルギー問題の規模を理解する

国際エネルギー機関(IEA)の試算によれば、2024年に世界のデータセンターが消費した電力は約415テラワット時であった。AIワークロードの需要が上昇し続ける中、この数値は2030年までに約945テラワット時とほぼ倍増する見込みだ。過去5年間で年間12%のペースで増加している。

IEAのファティ・ビロル事務局長はAIを「今日のエネルギー分野における最大の話題の一つ」と呼び、データセンターからの電力需要がまもなく国家全体の消費量に匹敵する可能性があると述べた。

|

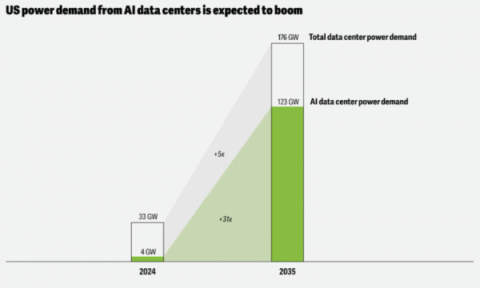

| 米国のAIデータセンターからの電力需要が急増すると予想される(出典:deloitte.com) |

「情報技術が生活に浸透するにつれ、データセンターによる世界の電力需要は今後5年間で倍増する見込みです」と、ビロールはIEAの2024年エネルギーとAI報告書に付随する声明で述べた。

「この影響は一部の国で特に顕著で、米国では電力需要増加分のほぼ半分をデータセンターが占めると予測さ れており、日本では半分以上、マレーシアでは5分の1を占める見込みです。」

既にこの変化は電力供給の方法と場所を変えつつある。テック大手は近接性やネットワーク速度のためだけにデータセンターを建設しているわけではない。安定した送電網、低コスト電力、再生可能エネルギー発電のためのスペースも追い求めているのだ。

ローレンス・バークレー国立研究所の研究によれば、2023年には米国だけでデータセンターが約176テラワット時の電力を消費すると予測されている。これは国内総需要の約4.4%に相当する。この拡大傾向は鈍化していない。今世紀末までに、新規プロジェクトにより消費量は約800テラワット時に達する可能性がある。これは80ギガワット以上の追加容量が稼働開始すると予測されているためだ——ただし、それらが予定通り完成した場合に限る。

デロイトの予測によれば、AIデータセンターからの電力需要は2024年の約4ギガワットから、2035年までに約123ギガワットまで上昇する見込みだ。こうした状況を踏まえると、次のクラスタ建設地を決定する要因が光ファイバーの経路や税制優遇ではなく電力供給力であることは驚くに当たらない。一部地域では、エネルギー計画担当者とテクノロジー企業が長期供給を確保するため直接交渉している。かつては計算能力と規模の問題だったものが、今やエネルギー問題へと変貌したのだ。

AIシステムがなぜこれほど電力を消費するのか

エネルギー依存の一因は、AIインフラのすべてのレイヤーが電力で稼働しているという現実にある。あらゆるAIシステムの核心は純粋な計算処理だ。大規模モデルを訓練・実行するチップが圧倒的に最大の電力消費源であり、毎秒数十億回の数学演算を実行している。Googleの試算によれば、Gemini Appsの平均的なテキストプロンプトは0.24ワット時の電力を消費する。これを毎日数百万件のテキストプロンプトに掛け合わせると、その数値は驚異的なものになる。

|

| (Kirill-Neiezhmakov/Shutterstock) |

これらのモデルを訓練・処理するGPUは膨大な電力を消費し、そのほぼ全てが直接熱に変換される(電力変換時の損失も加わる)。この熱は常に冷却システムを使って放散されねばならず、その冷却システム自体もエネルギーを消費する。

その安定性を維持するには、冷却システムやポンプ、エアハンドラーを絶え間なく稼働させ続ける必要がある。現代のアクセラレータを1ラック搭載するだけで、30~50キロワットを消費する。これは旧式サーバの数倍の電力だ。エネルギーはデータも運ぶ。高速インターコネクト、ストレージアレイ、電圧変換も負荷を増大させる。

需要の変化に応じて負荷が急増・急減した旧式メインフレームのワークロードとは異なり、現代のAIシステムは数日から数週間にわたりほぼフル稼働を続ける。この持続的な負荷は電力供給と冷却システムに絶え間ない圧力をかけ、エネルギー効率を単なるコスト要因からスケーラブルな計算基盤へと変容させている。

チップの性能向上に比例して電力問題が加速している

チップ性能の飛躍的な向上は、それを支えるシステムに同等の負荷を課す。エヌビディアやAMDの新世代製品は速度と効率への期待を高めるが、真の課題はチップの外側——それらを稼働させようとするデータセンターで顕在化している。かつて15~20キロワットを消費していたラックが、今では80キロワット以上、時には120キロワットに達する。配電ユニット、変圧器、冷却ループは、追いつくためだけに進化を迫られている。

かつてプロセッサ設計の問題だったものが、今では規模のエンジニアリング難題へと変貌した。半導体産業協会の2025年業界動向報告書はこれを「ワット当たりの性能の逆説」と表現している。チップレベルでの効率向上は、システム全体のエネルギー消費増加に追い越されているのだ。改良が進むほどに、より大規模なモデル、より長いトレーニング時間、より重いデータ移動が求められるようになり、チップがもたらすはずだった節約効果そのものが帳消しになっている。

|

|

| (Jack_the_sparow/Shutterstock) | |

この新たな需要に対応するため、事業者は空冷から液冷への移行、変電所のアップグレード、電力会社との直接交渉による数メガワット規模の接続を進めている。従来のサーバ向けに構築されたインフラは、演算密度ではなく電力供給を中心に再構築されつつある。チップの性能が向上するにつれ、それを支える物理的な世界――配線、ポンプ、送電網――はその進化に追いつくのに苦労している。

AI時代を支配する新たな指標:スピード・トゥ・パワー

地球上で最大のデータセンター内部では、静かな変革が起きている。純粋な速度を競う旧来の競争は、より根本的な課題——電力単位あたりの性能抽出量——に取って代わられた。このバランスは「速度と電力のトレードオフ」とも呼ばれ、現代AIを定義する方程式となっている。

FLOPSのようなベンチマークではないが、今やほぼ全ての設計判断に影響を与える。チップメーカーはワット当たりの性能を最大の競争優位性としてアピールしている。なぜなら電力網が処理できなければ速度は無意味だからだ。例えばエヌビディアの次世代GPU「H200」は、H100の約1.4倍のワット当たりの性能を実現する。一方AMDの「MI300」シリーズは大規模トレーニングクラスタ向けの効率性に重点を置いている。しかしチップが高度化するほど、より多くのエネルギー需要も生じる。

この動きはAIの経済性も変容させている。クラウドプロバイダは実行時間だけでなく消費電力に基づく課金を開始し、開発者にレイテンシではなくエネルギースループットの最適化を迫っている。データセンター設計者は面積ではなくメガワット単位の予算で設計し、米国から日本まで各国政府が省エネ型AIシステムの新規規制を打ち出している。

仕様書には決して記載されないかもしれないが、電力供給のスピードこそが、大規模な構築を可能にする企業を静かに定義している。一つのモデルが小さな都市並みの電力を消費する時代において、効率性は重要だ。そしてその重要性は、エコシステム全体が効率性を中心に再編成されている現状に表れている。

|

|

| (BESTWEB/Shutterstock) | |

AI覇権をめぐる競争

エネルギーが計算能力優位の新たな中心地となる中、大規模で信頼性の高い電力を供給できる政府や企業は、AI分野だけでなくデジタル経済全体で優位に立つだろう。アナリストはこれを「戦略的電力優位性」の台頭と表現する。この概念は単純明快でありながら影響は甚大だ。AIワークロードが急増する中、豊富で低コストなエネルギーを供給できる国々が、次の産業・技術成長の波を主導するだろう。

原子力発電と送電網拡張への迅速な投資がなければ、米国は2030年代初頭までに電力供給の信頼性リスクに直面する可能性がある。だからこそ議論の焦点はクラウド地域から電力地域へと移りつつあるのだ。

すでに複数の政府が核計算ハブ——小型モジュール炉とハイパースケールデータセンターを組み合わせた区域——への投資を進めている。他の政府は連邦所有地を活用し、核エネルギーとガス・再生可能エネルギーを組み合わせたハイブリッドプロジェクトでAIの電力需要増に対応している。これは物語の始まりに過ぎない。真の問題はAIに電力を供給できるかではなく、人類が自ら生み出した機械に追いつけるかどうかだ。

「AI時代のデータ活用」シリーズ次回以降では、企業がAIの野心を支えるため新たなエネルギー源に目を向ける様子、電力網自体が支えるシステムのように思考・適応するべく再構築される過程、そしてデータセンターが現代科学の実験室へと進化する様を検証する。さらに視野を広げ、米国、中国、その他の国々が、次世代の知能を駆動する電力とインフラの支配権を争う競争が展開されている現状にも目を向ける。

本記事はBigDATAwireに初出掲載されたものである。