Exascale Watch:El CapitanがAMD CPUとGPUを使用し、2 Exaflopsに到達

John Russell

HPEとその共同研究者、ローレンス・リバモア国立研究所(LLNL)に配置され、国家核セキュリティ管理局(NNSA)にサービスを提供する次期エクサスケールスーパーコンピューターであるEl CapitanがAMDの次世代「Genoa」Epyc CPUとRadeon GPUを使用し、当初のスペックより30%高い2 Expaflops (ピークダブルプレシジョン)性能を実現すると発表した。2023年に稼働が予定されている新システムは、現在世界最速のスーパーコンピュータである「Summitサミット」(2019年11月のTop500)よりも10倍速くなる見込みである。

AMDプロセッサテクノロジーの選択は、エネルギー省が昨年8月に約6億ドルのEl Capitan調達を初めて発表したときは行われていませんでした。現在、HPEの一部であるCray は、Shastaアーキテクチャの選択と同様に、主要な請負業者として発表されました。AMDプロセッサ技術の選択は、アメリカ合衆国エネルギー省が昨年8月に6億ドルのEl Capitan調達を初めて発表した時点ではなされていなかった。Crayは現在HPEの一部であり、Shastaアーキテクチャの選定と同様に主要な請負業者として発表された。CPU / GPUの選択の詳細とその他のいくつかのシステム要素は、LLNLのCTOであるBronis de Supinski、SVPのシニアフェローでありHPEのCTOであるSteve Scott、 AMDデータセンターおよび組み込みシステムグループのSVPおよびGMであるForrest Norrodによるメディアプレブリーフィングで発表された。

HPEは、Crayを通じて、これまで米国のExascale の賞レースで最大の勝利を収めた。インテルのCPU/GPUペアを持つAurora、別のAMDのCPU/GPUペアを持つFrontier、AMDプロセッサとAMDアクセラレータを搭載したEl Capitanの3つのシステムすべての契約を獲得した。El Capitanは、AMDプロセッサとAMDアクセラレータも搭載することが知られている。AMDは、2017年にEpycラインのCPUを搭載したHPCサーバー市場に再参入した後、ハイエンドサーバーのRadeon GPUとEpycをペアリングすることに軽く取り組んだ。それは明らかに変わった。

|

|

| Steve Scott、HPE / Cray | |

El Capitanのプロセッサ選択が遅れていることについて、Scottは次のように述べています。「他の人々も同様に使用しているDoE/LLNLが使用した戦略は、システムアーキテクチャを選択し、それを導入し始めること、その後プロセッサの選択をできるだけ遅くすることです。そうすることで、より良い可視性を得ることができます。あなたのヘッドライトが将来をさらに照らしているのです。プロセッサのロードマップは改善し続けており、後にその決定を下すことによって、最終的にはより良い結果が得られる傾向があり、それがまさにここで起こったことなのです。」

彼は新しいプロセッサのプロセス技術を特定することを避けたが、Genoaは5nmのプロセスで製造されると推測されていた。AMDのNorrodは「時間の経過とともに、これらのパーツの詳細を明らかにする予定です」と語った。「Genoaに関する次回の開示については、率直に言って…今週の木曜日である財務アナリストの日になるでしょう。」

El Capitanの主な使命は、NNSAの高度なシミュレーションおよびコンピューティングプログラムの中にあり、これは、シミュレーションを使用して、国の核備蓄が安全、確実で、信頼できることを証明するためのものである。「それを証明するためには複雑なシミュレーションが必要で、また核の蓄積が進むにつれてシミュレーションの複雑さは増大するだけであり、より大大規模なシステムを使用できるようにする必要があります」とde Supinskiは述べた。

El Capitanは、HPE / Crayの高度なスケール製品ラインの最新の更新の中核となるHPEのShastaアーキテクチャを活用する。他のコアコンポーネントには、新しいソフトウェアスタック、新しいSlingshotインターコネクトテクノロジー、新しいストレージシステムが含まれる。

「その新しいソフトウェアスタックは、ハイブリッドワークフローのためのより動的なクラウドのような環境を提供します」とScott氏は述べている。「ソフトウェアコンポーネント間で文書化されたAPIを公開しています。このシステムは、冗長なマイクロサーバで構築され、Kubernetesクラスタとして管理される管理システムを有し、また、このシステムの下で実行される任意のワークロードをユーザーが実行することを可能にするための強固なコンテナサポートも有しています。システム監視フレームワークはスタックの下で実行され、パフォーマンスを最適化して障害の予測に役立ちます。」

Scottはこれを将来性のある設計と呼び、「さまざまなプロセッサや電力量、さまざまなタイプの処理、さまざまな物理サイズのプロセッサやメモリシステムに対応するように設計されています。そして、今後ス年間で再びキロワット電力レベルまで戻るプロセッサを処理するための電力と冷却ヘッドルームを備えています」と述べた。

Scottによると、El Capitanは水冷式で、30~40メガワットのエネルギーバジェットを持ち、最終的には40MWよりも30MW近くになると予測されている。Slingshotおよび高性能イーサネットは、計画されたシステムインターコネクトを構成する。計画されているストレージシステムは、HPEの新しいClusterStor E1000であり、Scottは次のように述べている。「これはフラッシュパーティションとハードドライブパーティションを使用した非常に柔軟な階層型ストレージシステムであり、パフォーマンスと容量を個別に最適化することで、パーティション間のデータを賢く階層化することが可能になります。それによりSlingshotインターコネクトに直接接続され、コストと複雑さ、待ち時間を削減するのに役立つのです。」

|

|

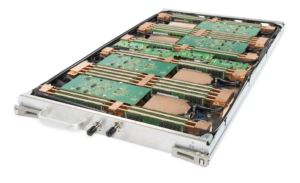

| Shasta Compute Blade | |

特定の性能仕様は、一般に開示されていない。新しいAMD CPU では、2021 年に開始予定のZen4 コアが使用され、新しいCPU-GPU ペアリング(AMD 用語ではA-plus-A)は、AMD のInfinity ファブリック3.0 を活用してメモリの一貫性を実現する。El Capitanの詳細なノード構造およびノード数はプレブリーフィングにおいて議論されなかったが、公式のプレスリリースでは、アーキテクチャを「データ集約型AI、機械学習、および処理をCPUからGPUにオフロードすることによる分析ニーズの性能を向上させるために、アクセラレータ中心のコンピューティングブレード(4:1のGPU対CPU比で、高帯域幅、短待ち時間接続のための第3世代AMDインフィニティアーキテクチャによって接続される)を使用する」と特徴付けている。

一般に異種アーキテクチャの場合と同様に、アクセラレータは、ほとんどの作業を処理し、効率的なIOを必要とする。Norrodは、「次世代メモリとIOサブシステムは、メモリへのノンブロッキングアクセス、IOへのノンブロッキングアクセスを提供し、Zen4 CPUエンジンとRadeon Instinct GPUエンジンのフルパワーを確保することが可能です」と述べた。

彼は、新GPUは高性能コンピューティングおよびマシンインテリジェンスアプリケーション向けに最適化されていると語った。「このディープラーニングパフォーマンスを最適化する広範な混合精度操作と、従来のHPCアプリケーションで単一および二重のピーク精度のパフォーマンスを提供することができます。パッケージには次世代の高帯域幅メモリ(HBM)メモリが組み込まれており、GPUという猛獣に再び餌をやるための、非常に重要なメモリ帯域幅と容量を提供します。」

|

|

多くのデータ分析ワークロードは高性能シミュレーションとは全く異なるように見えるが、Scottは、「高性能シミュレーションと多くの共通点があるワークロードの1つであることがわかりました。通常、計算に使用する粒度または精度はかなり異なります。AI のほとんどは16 ビットまたは32 ビットの精度で実行されますが、科学シミュレーションのほとんどは64 ビットの精度で実行されます。しかし、AMD GPUのような最新のプロセッサは、特定の計算に応じて機能ユニットを取得し、64ビットモード、16ビットモードまたは32ビットモードのいずれかで実行することができるのです。そしてそのためには、強力な相互接続と、科学的なワークロードと共通する非常に高いメモリ帯域幅が必要です」と述べた。

「私たちは、シミュレーションとAIワークロードの両方によく適した、非常に高いメモリ帯域幅およびインターコネクト帯域幅およびストレージ帯域幅と結びついた、柔軟な精度のCPUとGPUの組合せを見出し、システム内すべての計算ノードを使用して、これらのワークロードのいずれかにに耐えるようにすることが可能です」とScottは語る。

興味深いことに、LLNLにおいて、AIは現在、最優先事項ではありません。

De Supinskiは述べた。「私たちはリバモアで多くの研究開発を行っており、AIでシミュレーションを実現する方法を模索しています。一定の精度が必要ですが、ディープラーニングモデルは確率論的であるため精度の低い操作で十分であることがよくありますが、精度の低下によりエラーがどこにあり、どこが大きくなっているのかを理解し、次いで、必要とされる精度および精度を向上させるための何らかのメカニズムを組み込むことができなければいけません。」

プレブリーフィングでは、GPU以外のアクセラレータを使用するEl Capitanの能力について質問がなされた。Scottは、現在GPUがAIアクセラレータとして選択されているが、多くのユーザーが代替案を検討しており、El Capitanのシステムアーキテクチャは「そのような異種混合に対応できるように設計されています」と述べた。

De Supinskiは、LLNLが機密でないシステムであるLassenを使用しており、分類されたSierraシステムの姉妹マシンであることを指摘して、新たなAIアクセラレータについてより多くのことを学んでいると述べている。「私たちは、そのシステムに専用の機械学習アクセラレータを追加する方法を積極的に検討しています。私たちが実行しているメカニズムは、El Capitanで完全に利用できると期待しています。つまり、その目的専用に設計されたシステムにノードを追加することができるということです。私たちは、Lassenに関する探査的研究で物事がどのように進むかを見ていきます。それらがうまくいけば、それをどのように活用できるかを見出すために、HPEを利用する可能性が高くなるでしょう。」

AMD、HPE、およびLLNLは、El Capitan向けのソフトウェアツールで協力をしている。Norrodによると、計画の一部は、AMDのROCmフレームワークを活用して、OpenMP環境だけでなく他の環境でもコヒーレントアクセラレーションを利用することである。

|

|

Scottは、「この調達の一環として、エネルギー省は、非定期的なエンジニアリングの取り組みのため、機械の購入以外に追加資金を提供しています。その主要な部分の1つは、AMDと緊密に連携して、新しいCPU-GPUアーキテクチャのプログラミング環境を強化することです」と述べた。El Capitanが納入された際、重要なアプリケーションおよび作業負荷を前進させ、それらを最適化してマシンで最高のパフォーマンスを引き出すために、3つのパートナーすべてが作業を進めている。

De Supinskiは次のように強調した。「これは、特にソフトウェアのための協調プロセスです。システム用のソフトウェアのいくつかは、アプリケーションに加えてローレンス・リバモアで開発されています。たとえば、新しいシステム上で実行可能なオープンソース管理パッケージであるSpackを非常に期待しています。」

ブリーフィングでは議論されなかったが、公式発表で言及された興味深い特徴の1つは、El Capitanの光データ伝送の使用計画です。

リリースによると、「HPEはLLNLとのパートナーシップを拡大し、光を利用してデータを送信するコンピューティングソリューションであるHPE光学技術を積極的に探求し、DOEのEl Capitanに搭載しています。HPEの光学技術は、米国DOEのExascale Computing Projectが支援するプログラムであるPathForwardに関連するR&Dの取り組みから生まれました。HPEは、電気から光へのインターフェースを統合して、将来のクラスのシステムインターコネクトで幅広い使用を可能にする画期的な光学プロトタイプを開発し、実証しました。HPEとLLNLは、これらの光学技術をHPEのCray SlingshotとDOEのEl Capitanに統合して、より多くのデータをより効率的に送信する方法を検討しています。このアプローチは、電力効率、信頼性、およびグローバルシステムの帯域幅を費用効果的に増加させる能力を向上させることを目的としています」と説明されている。

光データ伝送は、多くの企業が積極的に実用化を模索している研究分野である。

El CapitanはNNSAの最速コンピュータとなり、NASAの、2Dシミュレーションではなく3Dシミュレーションを迅速に実行する機能を大幅に強化させる。LLNLはNNSAの新しいシステムを管理しており、研究者が備蓄の近代化と備蓄管理の重要な側面である慣性核融合(ICF)全体の主要なミッションのための、より高速で正確なモデルを作成できるようにする新しい技術を開発した。