推論モデルとは何か、なぜ気にすべきなのか

Alex Woodie オリジナル記事「What Are Reasoning Models and Why You Should Care」

DeepSeek R-1の急速な躍進により、推論モデルと呼ばれる新興のAIモデルタイプに注目が集まっている。生成AIアプリケーションが会話インターフェースを超えて進化するにつれ、推論モデルは能力と用途の両面で成長を遂げる可能性が高く、だからこそ、AIのレーダーに捉えるべきなのだ。

推論モデルは、複雑な推論タスクを実行できる大規模言語モデル(LLM)の一種である。LLMが通常行うように、回答の次の単語がどうあるべきかを統計的な推測のみに基づいて素早くアウトプットを生成するのではなく、推論モデルは質問を個々のステップに分解し、「思考の連鎖」プロセスを通じてより正確な回答を導き出すために時間をかける。このように、推論モデルはアプローチにおいてより人間に近い。

OpenAIは2024年9月、最初の推論モデル「o1」を発表した。同社はブログ投稿で、数学、科学、コーディングの複雑なタスクを処理できるように、強化学習(RL)のテクニックを用いて推論モデルを訓練したと説明している。このモデルは、物理学、化学、生物学では博士課程の学生レベルの能力を発揮し、数学とコーディングでは博士課程の学生の能力を上回る。

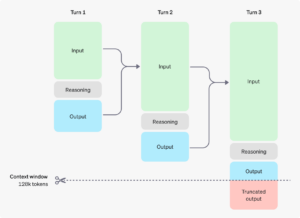

OpenAIによると、推論モデルは、以前の言語モデルと比較して、人間に近い方法で問題に対処する。

|

| 推論モデルは、追加のトークンを含む思考の連鎖プロセスを含む。(画像出典:OpenAI) |

「人間が難しい質問に答えるために長い時間をかけて考えるのと同様に、o1は問題を解決しようとする際に思考の連鎖を使用します」と、OpenAIは技術ブログの記事で述べている。「強化学習を通じて、o1は思考の連鎖を磨き、使用する戦略を洗練することを学習します。また、自身のミスを認識し修正することを学習します。さらに、複雑なステップをより簡単なステップに分解することを学習します。また、現在のアプローチがうまくいかない場合に別の方法を試すことを学習します。このプロセスにより、モデルの推論能力が劇的に向上します。」

IBMフェローのクッシュ・ヴァルスニー氏は、推論モデルは正しさを自ら確認できると述べ、これはAIにはこれまで存在しなかった「メタ認知」の一種であると述べている。「私たちは今、これらのモデルに知恵を吹き込み始めており、これは大きな一歩です」と、ヴァルスニー氏は1月27日のブログ投稿でIBMの技術記者団に語った。

そのレベルの認知能力にはコストがかかる。特に実行時に。例えば、OpenAIは、o1-miniの料金をGPT-4o miniの20倍に設定している。また、o3-miniはトークンあたりo1-miniよりも63%安いものの、GPT-4o-miniよりも大幅に高額であり、これは「思考の連鎖」と呼ばれる推論プロセスで使用される推論トークンと呼ばれるトークンの数が多くなっていることを反映している。

DeepSeek R-1の導入が画期的だった理由のひとつは、計算要件が劇的に削減されたことだ。DeepSeekの開発元は、OpenAIの最新モデルGPT-4のトレーニングに数億ドルかかったと報道されているのとは対照的に、550万ドルしかかからなかった旧型のGPUの小規模なクラスタでV-3モデルをトレーニングしたと主張している。また、入力トークン100万個あたり0.55ドルで、DeepSeek R-1はOpenAIのo3-miniの約半分のコストである。

数学、コーディング、科学のタスクにおいて、OpenAIのo1推論モデルと比較可能なスコアを記録したDeepSeek-R1の驚くべき躍進により、AI研究者はAIの開発と拡張のアプローチを再考せざるを得なくなっている。さまざまなソースから収集した膨大なデータでトレーニングを行い、何兆ものパラメータを持つLLMを構築することに躍起になるのではなく、DeepSeek R-1のような推論モデルの成功は、エキスパート混合アーキテクチャ(MoE)を使用してトレーニングされたより小規模なモデルを多数用意する方が、より優れたアプローチである可能性を示唆している。

|

|

急速な変化に対応しているAIリーダーの一人が、アリ・ゴドシ氏である。YouTubeに投稿された最近のインタビューで、DatabricksのCEOは推論モデルとDeepSeekの台頭の意義について語っている。

「ゲームは明らかに変化しました。大手研究所でも、彼らは全力を挙げてこれらの推論モデルに注力しています」と、インタビューの中でゴドシ氏は語る。「つまり、もはやスケーリングの法則に重点を置くことも、巨大なモデルを訓練することもありません。彼らは実際、多くの推論に資金を投入しています。」

DeepSeekと推論モデルの台頭は、プロセッサの需要にも影響を与える。ゴドシ氏が指摘するように、汎用的な何でも屋であるLLMのトレーニングから市場が離れ、大規模なLLMから抽出された小規模な推論モデルのトレーニングへと移行し、RL技術を使用して強化することで、特定の分野の専門家になるのであれば、必要なハードウェアの種類に必ず影響を与えることになる。

「推論には、さまざまな種類のチップが必要なだけです」と、YouTubeのビデオでゴドシ氏は語る。「GPUをインターコネクトしたネットワークは必要ありません。データセンターをどこにでも配置できます。GPUをあちらに配置することもできます。ゲームのルールが変わったのです。」

|

|

| エヌビディアのRTX GPU(出典:エヌビディア) | |

GPUメーカーのエヌビディアは、この変化が自社のビジネスに与える影響を認識している。同社はブログ投稿で、6710億パラメータのDeepSeek-R1モデルから抽出された小規模な学生モデルの一部を実行するPCベースのGPU(Blackwell GPUをベースとする)の50シリーズRTXラインの推論性能をアピールしている。

「高性能なRTX GPUがあれば、インターネット接続がなくてもAI機能が常に利用でき、また、ユーザが機密データをアップロードしたり、クエリをオンラインサービスにさらす必要がないため、低レイテンシとプライバシーの向上を実現できます」と、エヌビディアのアナマライ・チョッカリガム氏は先週のブログで述べている。

もちろん、推論モデルだけがすべてではない。LLMに正しい文脈を反映したデータを提示するためのビルド検索拡張(RAG)パイプラインの構築には、依然としてかなりの投資が行われている。多くの組織が、LLMに注入できる知識のソースとしてグラフデータベースを組み込む作業に取り組んでいる。これは、GraphRAGアプローチとして知られている。また、多くの組織が、独自のデータを使用してオープンソースモデルを微調整し、トレーニングする計画を進めている。

しかし、AIの分野に突如として推論モデルが登場したことは、間違いなく状況を揺るがすものだ。AIの進化のペースが加速し続ける中、このような驚きや衝撃は今後さらに頻繁に起こる可能性が高い。それは、私たちにとって起伏の多い道のりとなるかもしれないが、最終的にはより能力が高く、より有用なAIが誕生することにつながる。それは私たち全員にとって良いことだ。

関連項目: