H100は消滅: エヌビディア、H200を搭載した2024年のハードウェアを発表

Agam Shah オリジナル記事はこちら

スーパーコンピューティング愛好者はスピードの鬼であるため、エヌビディアがSupercomputing 2023で2024年のコンピューティング製品について説明することは理にかなっていた。

エヌビディアの次世代製品は、H200 GPUを中心に計画されており、来年第2四半期にクラウドプロバイダーやシステムベンダーを通じて発売される予定だ。

H200は、H100をさらに改良したもので、ヘビーデューティーなAIや高性能コンピューティング・アプリケーションを実行するために必要なメモリ容量と帯域幅を増やしている。

エヌビディアは、今年時価総額1兆ドルを突破したHopperベースのH100 GPUについて、もう語り尽くしたようだ。

ある意味で、SC23におけるH200の焦点は、エヌビディアがH100の普及を発表したSupercomputing 2022の再来である。

新しいHBM3eメモリは、アプリケーションにより多くの帯域幅とメモリ容量をもたらす。H100はHBM3メモリを搭載していた。

システムには141GBのメモリが搭載されており、H100のSXMおよびPCIeバージョンの80GBのHBM3メモリから改善されている。

H200のメモリ帯域幅は毎秒4.8テラバイトで、エヌビディアのH100は毎秒3.35テラバイトを誇っている。

製品名が示すように、H200はHopperマイクロアーキテクチャをベースにしている。メモリの改善以外では、H100とH200は、BFLOAT、FP、TFを含むほとんどの浮動小数点および整数の指標において同等である。H100と同様に、H200の熱設計限界は700ワットだ。

|

|

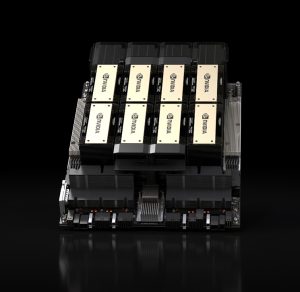

| エヌビディアの8ウェイHGX 200(出典:エヌビディア) | |

エヌビディアは、GPT-3でH100の1.6倍、Llamaで1.9倍高速であるとして、いくつかの比較推論ベンチマークを提供した。

H200は、2021年に出荷され、現在もクラウドで広く使用されているA100よりも、科学計算において2倍高速である。自動車会社のテスラ社は現在もAIにA100を使用しており、主要なクラウドプロバイダーはすべて、H100インスタンスよりも大幅に安価なA100 VMを提供している。

「シミュレーション、科学研究、人工知能のようなメモリ集約型のHPCアプリケーションでは、H200の高いメモリ帯域幅により、データへのアクセスと操作を効率的に行うことができます」とエヌビディアはスペックシートで述べている。

H200は、900GB/秒でデータを転送するエヌビディアのNVLinkインターコネクトにより、サーバーシステム内の複数のGPUと組み合わせることができる。また、128GB/秒の転送速度を達成できるPCIe Gen5もサポートしている。

IBM Cloudを除くすべての主要クラウドプロバイダーは、来年からH200インスタンスを提供する予定だ。

しかし、ここからが面白い。H100 GPUを23億ドルの負債の担保として活用してきたCoreWeave社は、同社のクラウドでもH200を提供する予定だ。

顧客は同社のLaunchpadサービスでH200をテストすることもできる。同社のAI Enterpriseソフトウェア・パッケージは、企業がGPU用のアプリケーションを開発することを可能にし、同社のCUDAソフトウェア・スタックは最近バージョン12.3に更新された。

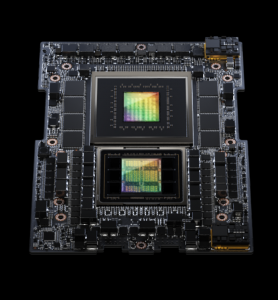

H200はエヌビディアのGH200チップセットの一部で、チップセット内にGrace CPUとHopper GPUをペアにしている。エヌビディアは、GH200チップを282GBのHBM3eメモリーを搭載したパッケージに接続したが、これは従来のGH100チップの192GBのHBMメモリーを改良したものだ。このチップセットは、8ペタフロップスのAIコンピューティング能力と10TB/秒のHBM3e性能を提供する。

SC23でエヌビディアは、基本的にマザーボード上に4つのGH200チップを搭載したクアッド・エヌビディアGH200チップも発表した。このチップパッケージは、288個のARMコア(Neoverse V2設計に基づく)を搭載し、6ペタフロップスのAI性能を実現し、2.3TBの高速メモリを搭載する。GH200 Quadは、Eviden Bull SequanaとHPEによるスーパーコンピューティング・スリードにも搭載される予定だ。

欧州初のエクサスケール・スーパーコンピューター「Jupiter」は、GH200チップを使用する。GH200は、AIやHPCアプリケーション向けにエヌビディアの技術をベースにしたブースターモジュールに搭載される。Jupiterのコアコンピュートモジュールは、ARM技術をベースにしたSiPearlのRhea1チップをベースにしており、ヨーロッパ初の国産CPUと考えられている。

欧州はコンピューティング・システムをオープン技術にシフトし、エヌビディアの全部入りGH200のような独自技術から離れようとしている。しかし、欧州にはネイティブGPUがなく、エヌビディアのGPU以外にエクサスケールに到達するためのブーストを提供する選択肢はあまりなかった。

SiPearl社のフィリップ・ノットンCEOは、「当初から、外部GPUと連携しなければならないことはわかっていました」と述べ、Rhea1 CPUとコアコンピューティングモデルについては、まだ多くの作業が行われていると付け加えた。同社は、シミュレーションモデルやその他のAI活動を実行するためにRhea1 CPUを設計している。

エヌビディアのGH200チップは、ブリストル大学のIsambard-AI、国立スーパーコンピューティング・アプリケーションズセンターのDeltaAIスーパーコンピュータにも搭載される予定だ。

エヌビディアは、グレース・ホッパー・チップを搭載したすべての主要な科学計算データセンターが、2025年までに合計350エクサフロップスのAI性能を実現すると主張している。

|

|

| エヌビディア・グレース・ホッパー(出典:エヌビディア) | |

エヌビディアは、H200 GPUを搭載した「HGX 200」と呼ばれるサーバーシステムも発表した。HGX 200は4ウェイまたは8ウェイのシステムで提供され、GPUをリンクするために最新のNVLinkおよびNVSwitchインターコネクトもパッケージ化される。

8ウェイのHGX 200は、32ペタフロップスのFP8 AI性能を実行できる。インテル、エヌビディア、ARMの3社は、FP8ベンチマークを性能の重要な尺度として定めている。

エヌビディアは以前、256基のGH200 GPU(現在はDGX GH200と呼ばれる)を搭載し、1エクサフロップのAI性能を実現するグレース・ホッパー・スーパーコンピューターを開発すると発表した。エヌビディアのジェンセン・フアン最高経営責任者(CEO)は、256基のGH200がすべて連動した場合、このシステムを「世界最大のシングルGPU」と呼んでいる。

エヌビディアは来年、まったく新しいアーキテクチャを採用したフラッグシップGPU「B100」をリリースする。2025年には、エヌビディアはX100 GPUをリリースする。同社はまた、フラッグシップ・チップの低性能版もリリースする。エヌビディアは最近、2025年に向けて毎年新しいAI GPUをリリースすると発表した。

エヌビディアがロードマップを早めているのは、競合他社との距離をもっと置きたいからだ、とティリアス・リサーチの主任アナリストは言う。

「同社は長い間、明確な優位性を持っていたため、世代間の時間をより長く取ることができました。また、半導体市場はチップレットという新しい時代に突入しており、エヌビディアのチップ設計方法も変化している可能性があります」と、クルーウェル氏は語った。

エヌビディアは、研究者が量子アプリケーションのシミュレーションに使用するエヌビディアCUDA Quantumで、スーパーコンピューティング2023の発表を締めくくった。量子コンピュータは簡単には入手できないため、エヌビディアのGPUスピードは、量子回路で処理されたかのようにアプリケーションをシミュレートする。

また、量子プロセッサーとGPUを組み合わせたコンピューティング環境の構築にも取り組んでいる。

BASFの研究者は最近、GPU上で24量子ビットのシミュレーションを行った。研究チームは今後、エヌビディアのスーパーコンピューター「Eos H100」で50量子ビットのシミュレーションを行う予定だ。Eos H100には、576台のDGX H100システムと4,608台のH100 GPUが搭載されている。