GoogleのAI特化新型スーパーコンピュータ「A3」は26,000個のGPUを搭載

Agam Shah オリジナル記事

クラウドプロバイダーは、より多くのAI火力を提供するためにGPUの軍団を構築している。恒例の開発者会議「Google I/O」で、Googleは26,000個のGPUを搭載したAIスーパーコンピュータを発表した。Compute Engine A3というスーパーコンピュータは、MicrosoftとのAI覇権争いで、より多くのリソースを投入して積極的な反攻を図っていることを示す一つの証左である。

|

|

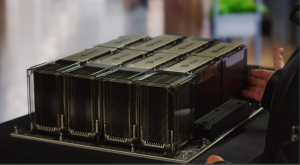

| 4月にNvidiaのジェンセン・フアン氏が示した、H100 Hopper GPUを8基搭載したNvidia DGX H100システムのベースボード | |

このスーパーコンピュータには、約2万6000個のNvidia H100 Hopper GPUが搭載されている。参考までに、世界最速のパブリックスーパーコンピュータ「Frontier」は、AMD Instinct 250X GPUを37,000個搭載している。

「最大の顧客に対しては、1つのクラスターに最大26,000GPUのA3スーパーコンピューターを構築でき、最大の地域で複数のクラスターを構築するよう取り組んでいます」とGoogleの広報担当者は電子メールで述べ、「すべての拠点がこの大規模な規模になるわけではありません」と付け加えている。

このシステムは、カリフォルニア州マウンテンビューで開催されている「Google I/O」カンファレンスで発表さ れた。この開発者会議は、グーグルのAIソフトウェアとハードウェアの能力の多くを紹介する場として登場している。マイクロソフトがOpenAIの技術をBing検索とオフィス生産性アプリケーションに入れた後、グーグルはAI開発を加速させている。

このスーパーコンピュータは、大規模な言語モデルの訓練を検討している顧客を対象としている。Googleは、スーパーコンピュータの利用を検討している企業向けに、A3仮想マシンインスタンスの添付を発表した。現在、多くのクラウドプロバイダーがH100 GPUを導入しており、Nvidiaは3月に独自のDGXクラウドサービスを開始したが、前世代のA100 GPUをレンタルするのに比べれば高価である。

Googleは、A3スーパーコンピュータは、NvidiaのA100 GPUを搭載した既存のA2仮想マシンが提供するコンピューティングリソースを大幅にアップグレードするものであると述べている。Googleは、地理的に分散しているすべてのA3コンピューティングインスタンスを1つのスーパーコンピュータにプールしている。

「A3スパコンの規模は、最大26エクサフロップスのAI性能を提供し、大規模なMLモデルのトレーニングにかかる時間とコストを大幅に改善します」と、Googleのディレクターであるロイ・キム氏とプロダクトマネージャーのクリス・クレバン氏はブログエントリーで述べている。

エクサフロップスという性能指標は、企業がAIコンピュータの生の性能を推定するために使用されるものだが、評論家からはまだ塩漬けにされた状態で見られている。Googleの場合、フロップスはMLをターゲットとしたbfloat16(「脳内浮動小数点」)性能で与えられ、ほとんどの古典的なHPCアプリケーションが依然として必要とする倍精度(FP64)浮動小数点演算よりもずっと速く「エクサフロップス」に到達することができるのだ。

GPUの数は、クラウド事業者がAIコンピューティングサービスをアピールするための重要な呼び水になっている。マイクロソフトがOpenAIと共同で構築したAzureのAIスーパーコンピュータは、28万5000個のCPUコアと1万個のGPUを搭載している。マイクロソフトは、さらにGPUを増やした次世代AIスーパーコンピューターも発表している。オラクルのクラウドサービスでは、512個のGPUのクラスタにアクセスでき、GPUの通信速度を高める新技術に取り組んでいる。

|

|

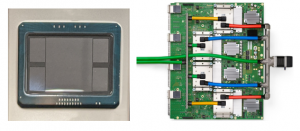

| Google TPU v4 画像提供:Google | |

Googleは、Googleが提供するBardなどのLLMで社内の人工知能アプリケーションを実行するために使用されているTPU v4人工知能チップを大々的に宣伝している。GoogleのAI子会社であるDeepMindは、高速なTPUが一般的かつ科学的なアプリケーションのためのAI開発を導いていると述べている。

それに比べ、GoogleのスーパーコンピュータA3は汎用性が高く、幅広いAIアプリケーションやLLMにチューニングすることが可能だ。「これらのワークロードの高い要求を考えると、画一的なアプローチでは不十分で、AI用に特化したインフラが必要です」と、キム氏とクレバン氏はブログエントリーで述べている。

GoogleがTPUを愛するように、NvidiaのGPUは、顧客がNvidia独自の並列プログラミングモデルであるCUDAでAIアプリケーションを書くことから、クラウドプロバイダーにとって必需品となった。このソフトウェアツールキットは、H100の特殊なAIコアとグラフィックスコアが提供するアクセラレーションに基づき、最速の結果を生成する。

顧客は、A3 VMを介してAIアプリケーションを実行し、Vertex AI、Google Kubernetes Engine、Google Compute Engineサービスを通じて利用できるGoogleのAI開発および管理サービスを使用することができる。

企業は、A3スーパーコンピューターのGPUを1回限りのレンタルとして利用し、大規模な言語モデルと連携して大規模なモデルを学習させることができる。そして、モデルに新しいデータを投入することで、一から再学習することなく、モデルが更新さ れる。

|

|

GoogleのA3スーパーコンピュータは、GPU間通信やネットワーク性能を高めるために、さまざまな技術を寄せ集めている。A3の仮想マシンは、インテルの第4世代Xeonチップ(コードネーム:Sapphire Rapids)をベースにしており、H100 GPUがパッケージングされている。VMの仮想CPUがSapphire Rapidsチップに内蔵された推論アクセラレータをサポートするかどうかは明らかではない。VMにはDDR5メモリが搭載されている。

Nvidia H100でのトレーニングモデルは、クラウドで広く利用されている前世代のA100 GPUよりも高速で安価だ。AIサービス会社MosaicMLが行った調査では、70億パラメータの大規模言語モデルMosaicGPTにおいて、H100は「NVIDIA A100よりも30%コスト効率が良く、3倍高速である」ことがわかったという。

H100が提供する処理能力の大きさを考えると、やり過ぎと思われるかもしれないが、H100は推論もできる。Google CloudではNvidiaのL4 GPUを推論用に提供しており、IntelはCPU「Sapphire Rapids」に推論用アクセラレータを搭載している。

|

|

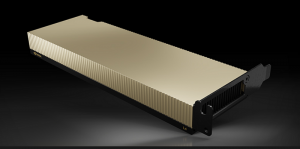

| NvidiaのGPU「L4」 画像提供:Nvidia | |

「A3 VMは推論ワークロードにも強く、当社のA2 VMのA100 GPUと比較すると、最大で30倍の推論性能の向上が見られます 」と、Googleのキム氏とクレバン氏は述べている。

A3 VMは、GoogleとIntelが共同開発したMount Evansと呼ばれるインフラストラクチャ処理ユニットを介してGPUインスタンスを接続した最初のものである。このIPUにより、A3仮想マシンは、従来は仮想CPUで行われていたネットワーク、ストレージ管理、セキュリティ機能をオフロードすることができる。IPUは200Gbpsのデータ転送を可能にする。

「A3は、カスタム設計の200Gbps IPUを使用した最初のGPUインスタンスで、GPU間のデータ転送はCPUホストをバイパスし、他のVMネットワークやデータトラフィックとは別のインターフェースで流れます。これにより、当社のA2 VMと比較して最大10倍のネットワーク帯域幅を実現し、低いテールレイテンシと高い帯域幅の安定性を実現しています」とGoogle幹部はブログエントリーで述べている。

IPUのスループットは、まもなくMicrosoftの挑戦を受けるかもしれない。Microsoftは、NvidiaのH100 GPUを搭載した次期AIスーパーコンピュータに、このチップメーカーのQuantum-2 400Gbpsネットワーキング機能を搭載する。Microsoftは、次世代AIスーパーコンピュータに搭載されるH100 GPUの数については明らかにしていない。

A3スーパーコンピュータは、同社のJupiterデータセンター・ネットワーキング・ファブリックから派生したスパイン上に構築されており、地理的に多様なGPUクラスターを光リンクで接続している。

「ほぼすべてのワークロード構造において、より高価な既製品のノンブロッキングネットワークファブリックと区別がつかないほどのワークロード帯域幅を実現しています」とGoogleは述べている。

Googleはまた、A3スーパーコンピュータが8つのH100 GPUを搭載し、Nvidia独自のスイッチング技術とチップインターコネクト技術を使って相互接続されることを明らかにした。GPUはNVSwitchとNVLinkインターコネクトで接続され、およそ3.6TBpsの速度で通信を行う予定だ。同じ速度はAzureがAIスーパーコンピュータで提供しており、両社ともNvidiaの基板設計を導入している。