インテルのXeonジェネラル・マネージャーがサーバー用チップについて語る

Agam Shah オリジナル記事「Intel’s Xeon General Manager Talks about Server Chips 」

インテルはデータセンターの成長について語っており、GPU、ストレージ、ネットワーキング製品など、縮小とコスト削減に陥った枯れたエンタープライズ製品の墓穴を掘るのはもう終わりだ。

チップメーカーの第5世代Xeonは、Emerald Rapidsと呼ばれ、同社がリリースした最も先進的なサーバーチップであり、予定通りに登場した。

Xeonチップは金のなる木であり、インテルはEmerald Rapidsに賭けるだろう。このチップの需要は健全で、すでに数百万個出荷されている第4世代サーバーチップSapphire Rapidsの成功と連動すると予想される。

パット・ゲルシンガー最高経営責任者(CEO)にとって、Xeonのコア数が多ければ多いほど、マージンは健全になる。Emerald Rapidsは最大64CPUで、第4世代チップの60コアから増加した。

しかし、第5世代Xeonは不安定な立場にある。レガシーXeonの最後の設計であり、新しいアーキテクチャと製造プロセスに基づく次世代サーバーチップであるGranite Rapidsへの足がかりでもある。

最も簡単な道は、Emerald Rapidsを手に入れることだろう。しかし、そうすれば顧客は、来年第2四半期過ぎに予定されているGranite Rapidsを手に入れるまで長く待つ必要はないだろう。

では、顧客はどうすればいいのか?HPCwireは、IntelのXeon製品担当コーポレート・バイス・プレジデント兼ジェネラル・マネージャーであるリサ・スペルマン(Lisa Spelman)氏と対談し、これらの質問に答えてもらった。HPCに特化したXeon Max CPUの将来性、物議を醸しているオンデマンド・チップ機能、開発者サポートなどにも話は及んだ。

HPCwire: Granite Rapidsは、新しいグランドアップサーバーデザインで、現在の第5世代Emerald Rapidsからそれほど離れていません。顧客はそれぞれをどのように考えるべきでしょうか?

スペルマン :私たちの目標は、さまざまなワークロードに対して、これまで以上に高いレベルのパフォーマンスとワットあたりのパフォーマンスを提供し続けることです。第1世代(Xeon)や第2世代(Xeon)を第5世代(Xeon)に移行すれば、標準的なワークロードを処理するためのラック数が減るため、運用コストを根本的に削減できます。

そして、Opexの節約分を吸収するか、節約した電力とスペースをAIの成長ワークロードに再投資することになります。

Graniteについて考えるとき、私たちが提供する次世代は、ハイパフォーマンス・コンピューティングに重点を置くことになるでしょう。HPCだけでなく、AIや、メモリ帯域幅と容量の進歩を伴う最も要求の厳しいワークロードという意味です。私たちは、両者が競合するものではなく、補完し合うものだと考えています。現在、顧客との間で交わされている会話の多くは、このようなものです。

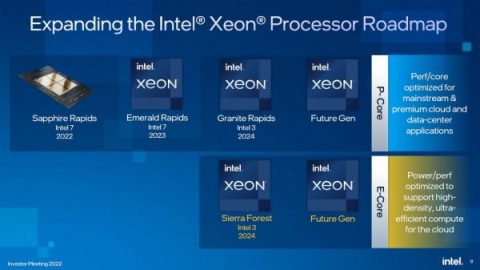

|

| インテル2024 Xeonロードマップ(提供:インテル) |

HPCwire: より高いパフォーマンスが必要ならGranite Rapidsへ、より高い電力効率とコスト削減が必要ならEmerald Rapidsへ、ということでしょうか?

スペルマン: 第5世代Xeonでは、特定のワークロードにおいて、キャッシュの向上が違いを生み、AMX周波数の向上も違いを生みました。

さまざまな作業負荷で21%の一般的な性能向上が見られ、1ワットあたりの性能向上も大きく、さらに特定の作業負荷ではそれ以上の向上が見られます。これらすべての組み合わせです。

Graniteを見ると、メモリが追いつくだけでなく、より多くのヘッドルームを確保するために、コア数がより大幅に飛躍するでしょう。だからこそ、Graniteは、その準備が整ったアプリケーションのための、より高性能なコンピューティング要件に焦点を当てたものになると言っているのです。あなたがEmeraldで目にしたものはすべて、Graniteでより大きな形で目にすることになるでしょう。

HPCwire: パット・ゲルシンガー氏はコア数を増やすことに積極的で、それが会社の収益を押し上げています。そして突然、Sierra Forestが144コアから288コアに増えました。コア数の少ないSierra Forestの廉価版が登場するのでしょうか?

スペルマン:私たちは常に最高のコア数を用意し、それをSKUしていきます。より少ないコア数のオプションも用意しますが、それでも144コアはかなりのコア数です。

低いコア数といっても8コアという意味ではなく、既存の第5世代Xeonがそのスペースの一部を埋めることになります。最終的には、このような低コア数を実現するGranite Rapidsも出てくるでしょう。

Sierra Forestも同じソケットで、より小型のEコア、より高い電力効率など、豊富で(より多くの)コアを搭載する予定です。SierraForestは同じソケットで、豊富で(多くの)コアが搭載され、より小型のEコアで電力効率に優れています。私たちはこのソケットをお客様に使っていただき、サービス提供のTCOをどのように改善できるかを調査しています。これにはかなり期待しています。

HPCwire :AI PCプロジェクトは、AI処理をサーバーチップからPCに移すチャンスです。クライアントCPUとサーバーCPUの間に、オフロードやソフトウェアの再利用に関する関係はあるのでしょうか?

スペルマン:ここ2、3年で、私たちは組織構造を改善しました。そのうちのいくつかは、”prodco “と “fabco “モデルへの移行です。製造チームが独立したビジネスへと成長し、そして製品チームがあります。私たちはより緊密になりました。私のチームと、アーキテクチャー・レベルでのクライアント・チームとのつながりは、かつてないほど強くなっています。

その結果、製品ライン全体の連続性を示すユースケースが生まれました。私たちは、AI PCで行われている作業をデモし、ブレイクポイントに到達してXeonにキックし、次のブレイクポイントでGraniteを必要とするつもりです。インテルにとって、我々が差別化されていると言うのは良いことですが、我々がより追求しているのは、ユーザーの介入を必要としないシームレスなフローという顧客価値なのです。

HPCwire: Emerald Rapidsのチップは2ソケットサーバーにしか搭載されていません。例えば8ソケットシステムの需要はありますか?

スペルマン: オンプレミスのOEMだけでなく、クラウドサービスプロバイダーの多くが8ソケットのインスタンスを用意しています。SAP HANAは非常に価値の高いワークロードです。ミッションクリティカルなタイプのアプリケーションは、テストや開発期間が長くなります。顧客と協力して、私たちは総体的にそれが必要だとは感じませんでした。

また、検証作業もかなりの量になります。そこで、エコシステムとともに、第4世代Xeon(Sapphire Rapids)で提供することを決定しました。Granite RapidsやSierra Forrestに対応できるようにリソースを確保するため、第5世代での提供は見送ります。それは正しい判断であるだけでなく、顧客の導入スケジュールにもより合致していると感じました。

HPCwire: Emerald Rapidsを搭載したXeon Maxのバージョンはありません。Maxの将来はどうなるのでしょうか?

スペルマン:ワークロードやユースケースと、HBMの正確な実装という観点から考えています。

特にハイパフォーマンス・コンピューティングのユースケースでは、Maxは優れた性能と価値を発揮します。

しかし、次世代製品に目を向けると、私たちは同じ領域で継続的な改善を提供するために絶対的な努力をしていますが、必ずしもHBMと同じように統合しているわけではありません。

Granite RapidsやMR-DIMM(Multi-Ranked buffered DIMM)などを見ると、私たちはより消費しやすいフォームファクターで、膨大な量のメモリ帯域幅とメモリ容量能力を提供しています。

同じTDPエンベロープの標準的なDIMMスロットにこれを搭載する能力を見ると、顧客は文字通り標準的なDDR、MR-DIMM、ワークロードのタイプを選択することができます。要約すると、チームと私が追求し、実現し続ける非常に重要なワークロードと性能目標がありますが、それは常に統合HBMという同じハードウェア・メカニズムを通じて実現されるわけではありません。

HPCwire: Emerald Rapidsは、機能レンタルサービスとして議論を呼んでいるオンデマンド機能と、Xeonチップのリモートオン/オフ機能をサポートしています。それは何ですか?

スペルマン:オンデマンドのロードマップには非常に期待しています。第4世代と第5世代については、私たちにとってはちょっとした練習台です。機能のアクティベーション、QAT(QuickAssist Technology)の追加インスタンス、SGX(Software Guard Extensions)のエンクレーブサイズの増加など、さまざまなことを試しています。エコシステムと協力し、顧客、システム、インフラ、その他すべてにこの機能をどのように組み込むかについてフィードバックを得ることができたのは良かった。

ロードマップのもう少し先を見てみると、数年前に行われた4対1のネットワーク統合のような形で、数年かけてエッジに能力を投入していく人々が目に浮かびます。今後2、3年の間に、人々がエッジに能力を投入するのは目に見えています。しかし、彼らはより多くのAIやワークロードを導入し、オンデマンドで提供する次世代に登場する新しいものを求めるようになるでしょう。我々はいくつかの調整と微調整を行いました。そこには大きな市場機会のようなものがあります。

HPCwire: オンデマンドでは、顧客は何を支払う必要があり、どのように機能するのでしょうか?クラウドプロバイダーも利用できるのでしょうか?

スペルマン: 私たちが考えているのは、この機能を私たちの顧客であるシステム・プロバイダに提供し、その上で彼らがビジネスを構築できるようにすることです。そのため、セットアップに少し時間がかかっています。もし、インテルが直接エンドユーザーと取引するのであれば、もっと早くできるかもしれませんが、同じようなエコシステムのサポートは得られません。

OEMがこの機能を提供するのを見ることができれば、それがオンプレミ・データセンターであろうとエッジ・データセンターであろうと、彼らはサービスを立ち上げるでしょうし、立ち上げつつあるでしょう。[例えば)OEMは、このようなサービスを提供するセキュリティ事業を持っています。さまざまなコアや周波数レベルなど、いくつかの概念実証を行いました。

HPCwire: エヌビディアは、採用の手助けとなるような、業種向けのAIソフトウェアパッケージを持っています。あなたも同じように、特定の業種向けにパッケージ化するのでしょうか?

スペルマン:それは間違いなく意図していることです。まず、水平的な基盤を整え、その上に垂直的なものを構築する必要があります。この秋、私たちはVMwareとのプライベートAIソリューションを発表しました。VMwareはエヌビディアのソリューションを持っており、今回はXeonのソリューションです。VMwareはこのソリューションに参加することに非常に意欲的で、素晴らしいパートナーシップです。

VMwareはこの提携に非常に意欲的で、素晴らしいパートナーシップです。ソフトウェアをパッケージ化することで、顧客は何日もかけてGitHubからダウンロードしなくても、既存のVMwareソリューションからダウンロードできるようになります。私たちはVMwareと一緒にそれに取り組んでおり、その上に垂直型のソリューションを構築していくつもりです。オープンソースのRed Hat OpenShiftでも同じことをするつもりです。

HPCwire :垂直的なプレゼンスを構築するために、収益分配によって開発者エコシステムにインセンティブを与えていますか?

スペルマン: インテルが学び、取り組んでいる教訓のひとつは、開発者の仕事を楽しくすることです。GitHubを探し回るのは楽しいことではありません。簡単に始められるようにすれば、開発者は “1時間あればできる “というような感覚で作業できるようになります。

生成AIの可能性の多くは……頭脳をクールな仕事に集中させ続けることです。私たちは、その土台を簡単なものにしようとしています。そして、あなたがおっしゃったような、収益分配のような、より高度なことが必要かどうかを考えたいと思います。

Xeonでは、膨大な量の推論を実行しています。私は、開発者がハードウェアのことを考えるのに多くの時間を費やす必要がないところまで来てほしいと思っています。理想的には、Pytorchを使って、あるレベルのオーケストレーションができるようになれば、インフラを認識するだけで、ストレスを感じる必要がなくなります。