NVlink: データのボトルネックを解消する高速インターコネクトとスイッチ

Alex Woodie オリジナル記事 「NVlink: Faster Interconnects and Switches to Help Relieve Data Bottlenecks」

Nvidiaの新しいBlackwellアーキテクチャは、今週カリフォルニア州サンノゼで開催されたGPU Technology Conferenceで注目を集めたかもしれない。しかし、ネットワーク層における新たなボトルネックは、AI、HPC、ビッグデータ分析ワークロードにとって、より大型で強力なプロセッサーを無意味なものにしてしまう恐れがある。良いニュースは、NvidiaがNVLink 5.0システムバックボーン、ストレージ接続用の800Gb InfiniBandおよびイーサネットスイッチを含む新しい相互接続とスイッチでボトルネックに対処していることだ。

Nvidiaは、その高速NVlink技術の最新の改良により、システムレベルでボールを前進させた。第5世代のGPU-GPU-CPUバスは、毎秒100ギガバイトの速度でプロセッサ間のデータ転送を行う。GPUごとに18のNVLink接続があるため、Blackwell GPUは、他のGPUまたはHopper CPUとの合計帯域幅が毎秒1.8テラバイトとなり、これはNVLink 4.0の2倍、業界標準のPCIe Gen5バスの14倍の帯域幅となる(NVLinkは、NVHSと呼ばれるNvidiaの高速シグナリング相互接続プロトコルをベースにしている)。

Nvidiaは、GB200 NVL72フレームの上に真に巨大なGPUスーパーコンピュータを構築するためのビルディングブロックとしてNVLink 5.0を使用している。NVL72の各トレイには、GB200 Grace Blackwell Superchipが2基搭載されており、各トレイには1基のGrace CPUと2基のBlackwell GPUが搭載されている。フル装備のNLV72フレームは、36個のGrace CPUと72個のBlackwell GPUを搭載し、48Uラック2台を占有する(CPUとGPUの数を半分にして1ラックに収めたNVL36構成もある)。これらのNVL72フレームを十分に積み重ねれば、DGX SuperPODが完成する。

|

|

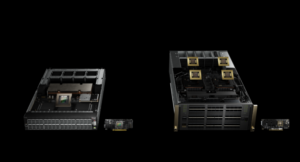

| 第5世代のNVLinkインターコネクト(画像提供:Nvidia) | |

本日発表されたNvidiaのブログ記事によると、液冷NVL72フレーム内のGrace Blackwell Superchipsをすべて接続するには、全部で9つのNVLinkスイッチが必要になるという。「Nvidia GB200 NVL72は、第5世代のNVLinkを導入しており、1つのNVLinkドメインに最大576のGPUを接続し、1PB/秒以上の総帯域幅と240TBの高速メモリを実現する」とNvidiaの著者は書いている。

Nvidiaのジェンセン・フアンCEOは月曜日のGTC基調講演で、インターコネクトのスピードに驚嘆した。「我々は、すべてのGPUを他のすべてのGPUと同時にフルスピードで会話させることができます。正気の沙汰とは思えません」とフアンは語った。「これは、1つのラックでエクサフロップのAIシステムです。」

Nvidiaはまた、大規模言語モデル(LLM)のトレーニングやその他のGPU負荷の高いワークロードを実行するために、複数のNVL72フレームを単一のネームスペースに接続する新しいNVLinkスイッチもリリースした。これらのNVLinkスイッチは、メラノックスが開発したSHARP(Scalable Hierarchical Aggregation and Reduction Protocol)プロトコルを利用して最適化とアクセラレーションを行い、それぞれ130TB/秒のGPU帯域幅を可能にするという。

このネットワーク帯域幅と計算帯域幅はすべて、LLMのトレーニングに有効利用される。最新のLLMは数兆ものパラメーターに達するため、トレーニングには膨大な計算量とメモリ帯域幅が必要となる。このような巨大なLLMを1つ訓練するには、複数のNVL72システムが必要になる。Huang氏によると、8,000個のHopper GPUで90日かかった同じ1兆8,000億パラメータのLLMを、わずか2,000個のMaxwell GPUで同じ時間で訓練できるという。

|

|

| Grace Blackwell Superchipsを2個搭載したGB200コンピュートトレイ(画像提供:Nvidia) | |

前世代のHGX H100キットに比べて30倍の帯域幅を持つ新しいGB200 NVL72システムは、GPUあたり毎秒最大116トークンを生成できるという。しかし、Nvidiaによれば、この馬力はビッグデータ解析などにも有効で、データベースの結合時間が18分の1に短縮されるという。また、物理ベースのシミュレーションや数値流体力学にも有効で、CPUベースのアプローチと比較して、それぞれ13倍と22倍の改善が見られるという。

NVLink5.0によってGPUクラスタ内のデータフローを高速化することに加え、Nvidiaは今週、GPUクラスタと、AIトレーニング、HPCシミュレーション、分析ワークロード用のビッグデータを保持する巨大なストレージアレイを接続するための新しいスイッチを発表した。同社は、イーサネットとInfiniBandの両方で毎秒800Gbのスループットを実現するX800ラインのスイッチを発表した。

X800ラインには、新しいInfiniBand Quantum Q3400スイッチとNVIDIA ConnectX-8 SuperNICが含まれる。Q3400スイッチは、NvidiaのSHARP(Scalable Hierarchical Aggregation and Reduction Protocol)v4により、帯域幅容量が5倍、総計算能力が9倍向上する。一方、ConnectX-8 SuperNICは、コンピュート・ファブリック全体で最大48レーンをサポートするPCI Express(PCIe)Gen6テクノロジーを活用している。このスイッチとNICを組み合わせることで、1兆パラメータ規模のAIモデルを訓練できるように設計されている。

|

|

| Nvidia X800シリーズのスイッチと関連NIC(画像提供:Nvidia) | |

非InfiniBandショップ向けに、Nvidiaの新しいSpectrum-X800 EthernetスイッチとBlueField-3 SuperNICは、最新の業界標準ネットワーク接続を提供するように設計されている。800GbE機能を搭載したSpectrum-X SN5600スイッチ(すでに400GbE用として生産中)は、400GbEバージョンの4倍の容量を誇り、毎秒51.2テラビットのスイッチ容量を実現する。一方、BlueField-3 SuperNICは、リモート・ダイレクトメモリー・アクセス(RDMA)技術を利用して、GPUに低レイテンシーのデータを流し続けるのに役立つ。

Nvidiaの新しいX800技術は、2025年に利用可能になる予定だ。クラウドプロバイダーのMicrosoft Azure、Oracle Cloud、Coreweaveはすでにサポートを表明している。また、Aivres、DDN、Dell Technologies、Eviden、Hitachi Vantara、Hewlett Packard Enterprise、Lenovo、Supermicro、VAST Dataといった他のストレージプロバイダーも、X800ラインに基づくストレージシステムの提供を約束しているとNvidiaは述べている。