HPCとクラウド ~課題と将来像~ 1/4回 『変化する大型計算機センターの役割』

スポンサー記事

HPCワークロードをクラウド環境で実現するアイデアは随分長いこと話されているが、なかなか普及していない。これは日本だけの問題なのか?それとも世界的にHPCのクラウドへの展開は進んでいないのだろうか?

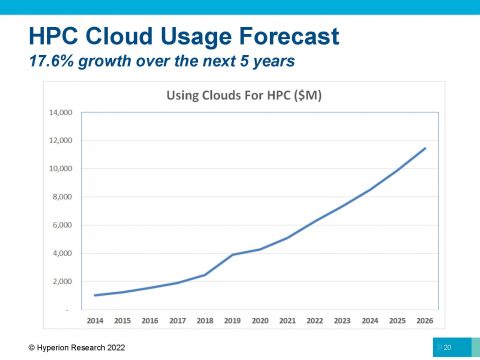

ハイペリオン社の予測では次の5年間でHPCクラウドは年間17.6%成長する見込みで2026年には約120億ドルになる予想だ。これは2021年におけるオンプレミスのHPC市場の全体規模である148億ドルに迫る勢いだ。それにも関わらず日本では依然としてリアルマシンであるスーパーコンピュータの調達が続いている。HPCのクラウド化が進まないのがどこに問題があるのか?HPC側なのか?それともクラウド側なのか?

今回の対談ではPCクラスタコンソーシアム主催で2022年6月23日、24日に開催されたPCクラスタワークショップ in 神戸2022「クラウドとHPC」を元に、九州大学情報基盤研究開発センター先端計算科学研究部門の南里豪志准教授、NVIDIA HPC/AI ネットワーキングプロダクトマーケティング部マーケティング ディレクター 岩谷正樹氏、NVIDIA エンタープライズ マーケティング部マーケティングマネージャ 愛甲浩史氏の三名の方に、HPCとクラウドの間に積まれた課題と将来像について話を伺いました。この対談内容を4回に分けてお届けします。

|

HPCwire 西克也(以下、HPCwire):

南里先生、岩谷さん、愛甲さん、本日は「HPCとクラウド」という観点でお話を伺いたいと思います。最初のテーマは九州大学情報基盤研究開発センターを含め文部科学省系の大型計算機センターでは近年、学外からの利用や、スパコンの利用用途の拡大など、以前の大型計算機センターとは状況が変化していきているのではないかと思います。実際にどのように変化しているのでしょうか?

九州大学 南里豪志 准教授(以下、南里):

まず昔、さらにもっと大昔のことを思い出してみますと、例えば九大のセンターにPCクラスタが入って来たのは2007年頃今から15年ぐらい前でした。その頃までは、研究室でお金がない人たちがパソコンを繋げて自分たちでクラスタを組んでやっていました。PCクラスタを大計センターに入れるのがありなのかという議論をした記憶があります。

我々は大きな予算ももらってやっているんだから、もっときちんとした、いわゆるスーパーコンピュータを入れるのが我々の役目なんじゃないかという議論がそもそもありました。しかし今はもうご覧の状況でPCクラスタ以外はほとんど入っていない状態になりました。この理由を考えますと、そもそも研究室で入れられる規模には限界があって、予算もそうですし場所もそうですし、電気もそうですし、あと手間もかかります。PCクラスタを導入するには大体研究室の学生が1人2人張り付いてやっていましたし、故障したら自分達で交換していました。研究室できちんと冷房が効いていて運用できる場所を確保するだけでも大変でした。

そういう状況で、やはり個々の研究室でできないことを代わりにやってくれる場所というような立場で、大型計算機センターが見直されてきたのが2007年2008年ぐらいの時期だったと思います。ですので、必ずしも圧倒的な他にないようなコンピュータとは違う感じですし、もう少し普段使いの便利に使える計算機センターっていう役割を含み始めたと思います。研究室の人たちが現在何をやろうとしているかというと、昔ながらのシミュレーションやっている人もいるし、機械学習の人もいる、という感じです。昔ながらのシミュレーションの人というのは、あまり研究室の計算機でできる計算というのは多くはないと思いますので、大体が大計センターをずっと使っていただいています。

|

|

機械学習の人については、これまでは研究室で最新のGPUを入れたパソコンを1台2台買ってきて、いろいろやって、だんだんメモリが足りないとか、やっぱりたくさん同時に実行したいとかとに変わってきて、クラウドなのか、それとも大計センターなのかというところを探し始めている感じです。だから機械学習の人にとっては、まだどっちにするか決まっていません。できれば研究室の中で全部できればそれが一番ハッピーだとまだ思われてると思うんです。ですが、そこに収まりきれない人が、次のところを探してると思ってます。あともう一つ、更に新しい利用として、例えばデータ駆動と呼ばれてるものがあります。データが最初にあって、それに応じて研究だったり、いろんなことをやりたいという人たちが出てきています。

これまでは計算をする人の方が主体だったので、ちょっとくらい計算機が落ちててもその間別のことやったり寝てたりすれば良かったのですが、いざデータとなると、四六時中誰かがアクセスしたり、動いてたり、変わったりするので、これにはオンプレミスはさすがに対応しにくいのが我々の問題意識としてあります。

特にオンプレミスの大計センターは年間いくらという予算で計算機をリースして、それもなるべく稼働率100パーセントに近い状態でずっと計算サービスをやっています。だから冗長性がほぼゼロに近い状態です。故障したらその分リソースが減ったり、下手したらサービス全停止になったりとか。そうするとハードディスクにファイルの読み書きすらできないっていう状態になります。

これはデータ駆動的なものとかデータサイエンス的な利用とかにはなかなか相容れない状況です。例えば、センサーデータを集めてくるっていうのはわかりやすいですね。いろんなセンサーから出てきたデータが不定期に届いてそれをずっと溜めておかないといけない。溜めたデータだったり、自分たちで計算した結果をまたコミュニティの中で共有をするっていうと、その共有するデータも四六時中いつでもアクセスできるようになってないといけません。だから、その部分はやっぱりオンプレミス型では対応できない一番わかりやすい部分だと思っています。この点に関しては、今後も冗長性、可用性の高いクラウドサービスとうまく連携しながら、お互いに補完しながら進めていけると嬉しいと思っています。

HPCwire:

時代の変化から、現在の状況、将来の課題までお話いただいてありがとうございます。岩谷さん、ベンダー側から見たお客様の変化っていうのはどのように感じられていますか?

NVIDIA 岩谷正樹氏(以下、岩谷):

南里先生のお話は最もだと思います。我々ベンダーから見ると、やはり近代から見た国内データセンターは、従来のクラシカルHPCを基盤としたデータセンターがスーパーコンピュータといわれるものを使っていたのが、だんだんPCクラスタ、日本でRWCPがPCクラスタのオープン系のオペレーティングシステムでScore作ったっていうのもあって発展してきて、そこから大学でもPCクラスタを導入していくようになったのかなと思っています。

そういった中で最近のデータセンターとして一番大きなところは、共創、協業が増えてきて、その研究所あるいは大学の中のユーザだけではなくて、いろんな公募だとかやりながら外部からのユーザが多くなってきています。

そして計算される内容も、従来のシミュレーションだとか計算科学といったいわゆるスーパーコンピューターを使うCPUベースのクラスタ計算から、AIを使った計算で、先ほど南里先生もおっしゃるようなAIという世界が入ってきたことによって、分野が様々に広がってきています。

例えば医療系、地質学、応用化学、バイオなど、データセンターを新たに使っていく新たなユーザが創設されています。それが内外で起こっているのです。それだけではなく、外部ユーザと内部ユーザが共同研究をしたり、今まではある程度分野、分野にわかれて研究されていたのが、ある意味共同研究によって垣根が薄まってきているところが大きな特徴かと思っています。

|

|

そうした中で今後お客さんというかユーザの中には先ほど南里先生が言われたように、従来のクラシカルHPCで計算が賄えるもの、あるいはいろいろなデータセンターが昨今様々にトライしているAI学習のためのGPUを基としたシステムでできるもの、そしてもっと別のユーザで、リアルタイムにシステムが欲しいというユーザ、先ほど言われたデータサイエンス系の話ですが、そういったユーザなど様々なデマンドが増えてきています。こういうデータセンターに集まってくるユーザにいかにスムーズにお客様の要望に合わせたマシンを提供できるのかというのがこれからのデータセンターの課題なのではないかなと我々は考えています。

次回につづく

|

|

第1回 | 第2回 | 第3回 | 第4回 |