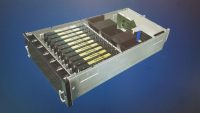

Dell、最大10個のGPUを搭載した2ソケット、4Uサーバを発売

Doug Black

Dell EMCは、4、8、10台のNvidia Tesla V100 GPU(プロセッサあたり14個の単精度テラフロップス)と最大8台のNVMeローカルストレージドライブを搭載した、データセンター用と最先端の、同社のAIサーバ製品群の中で最も強力な機械学習サーバを発売した。

つまり、たくさんのデータ、たくさんの計算パワー

Dell Technologies Worldの2日目に発表されたDell EMC DSS 8440は、MLアプリケーションおよびその他の要求の厳しいワークロード用に設計された2ソケットの4Uサーバである。このサーバは機械学習のルーキー向きではなく、より速いトレーニングとより速いトレーニングの繰り返しが重要となる、より多くのデータを利用する、より洗練された複雑なモデルを使用するまでに進んだ組織のために作られている。

「AIを始めたほとんどの人は8つものGPUを必要とはしていません」とDell EMCのシニア品質エンジニア、David Hillenmeyerはラスベガスでの事前発表イベントで講演した。 「これは非常に強力な箱ですが、出発点ではありません。機械学習がどこに役立つか知識を得ようとされているのであれば、そのお客様がどこにいるのかに応じて、お客様が展開できるさまざまな製品、サーバ、およびアクセラレータをご提案することができます。」

それは、最大3台のGPUをサポートするDell EMCの740および7425サーバ、最大4台のアクセラレータをサポートする4140などである。

DSS 8440は、大量のデータを処理するクラウドネイティブアプリケーションの開発によって推進される機械学習処理機能を提供するように設計されているとHillenmeyerは語った。高性能処理能力を超えて、サーバは4つのMicro-Semi 96レーンPCIeスイッチと8つのx4 NVMe PCIeスロットを備えた高速I / Oを備えている。

Hillenmeyerによると、サーバ内のGPU数が4から10に増えても、パフォーマンスは正確に直線的に拡大することはない。彼が共有したデータによると、Tesla V100を1つ使用した場合の画像認識ワークロードではトレーニングが約1,000分かかるのに対し、8 V100の場合は約180分、言語翻訳の場合1つのv100でのトレーニングは275分かかるのに対し、8つのNvidiaプロセッサでは50分になることを示した。

このサーバは、プロセッサあたり最大24コアの最も強力なIntel Xeon Scalable CPUもサポートしている。

DSS 8440は、最大10台の2.5インチデバイス、つまり32 TBのNVMeストレージをサポートできるため、Hillenmeyerは「トレーニングデータを大量に取得してすばやくアクセスし、トレーニング時間を短縮できます」と述べている。

DSS 8440は業界標準のPCIeファブリックをベースにしたアクセラレータ、ストレージオプション、ネットワークカードのカスタマイズが可能なオープンアーキテクチャを採用している、と同社は述べた。「このプラットフォームは、この分野で登場する新しいテクノロジをサポートするため、オープンになるよう設計されています。」「Dell EMCと共同開発したGraphcoreの機械学習IPUプロセッサを含み、今年後半にはFPGAと共にリリースされる予定です。」とHillenmeyerは語った。

Hillenmeyerはさらに、サーバはコアデータセンターで使用することも、低遅延を必要とする作業負荷のためにエッジで使用することもできると述べた。 「大量のデータの生成について話しているときは、すべてのデータをコアに戻す必要はなく、データを生成している場所にこのボックスを移動することができます。」

これは今四半期に出荷予定である。

この原文は姉妹誌のEnterpriseAI.newsに掲載されていたものです。