AWS、新しいP4 A100インスタンスで4,000GPUのUltraClustersを実現

Tiffany Trader

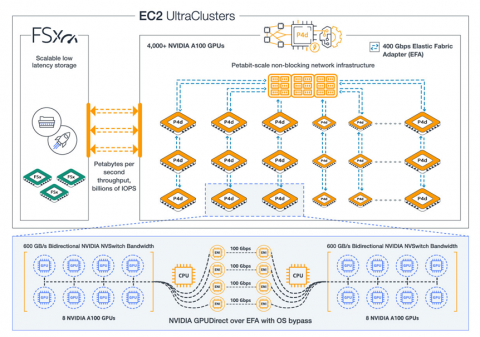

Amazon Web Servicesがこの技術を採用した最新のパブリッククラウドベンダーとなったことで、NvidiaのA100 GPUがクラウドに導入されている。A100 GPUはAWSの新製品であるPシリーズインスタンスに採用され、4,000以上のGPUを搭載したEC2「UltraClusters」を構成するために利用することができる。

|

|

| Nvidiaの8-GPUHGXA100「ベースボード」はP4dインスタンスを支えている | |

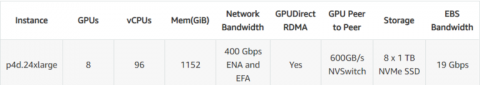

本日発表されたAWSの新しいP4dインスタンスは、NVLinkで接続された8つのA100 “Ampere “GPUと48個のIntel Cascade Lakeプロセッサコア(96個のvCPU)によって構成されている。AWSによると、新しいインスタンスは400Gbpsのネットワークを持つ初めてのもので、Elastic Fabric Adapter(EFA)とNvidia GPUDirect RDMA(リモートダイレクトメモリアクセス)を活用しているという。

各8-GPUインスタンスは、最大2.5ペタフロップスの16ビット・Tensor性能(従来の64ビットでは77.6テラフロップス)と320GBの高帯域幅GPUメモリを提供し、1.1テラバイトのインスタンスメモリと8テラバイトのNVMEベースのローカルSSDストレージ(1秒間に最大16ギガバイトの読み取りスループットを実現可能)を提供する。

AWSによると、P4dは、前世代のv100ベースのP3インスタンスと比較して、ディープラーニング性能が2.5倍、倍精度浮動小数点性能が2倍、メモリが2.5倍、ネットワーク帯域幅が16倍、ローカルのNVMeベースのSSDストレージが4倍となり、最大60%のコスト削減を実現しているという。

400Gpbsのネットワークは、専用のペタビット・スケールのノンブロッキング・ネットワークファブリックを介して4つの100Gbpsのネットワーク接続で提供され、EFA経由でアクセスできるという。AWSのチーフエバンジェリストであるJeff Barは、このソリューションは、最大80,000 IOPSで19GbpsのEBSバースト帯域幅をサポートしており、P4インスタンスのためにカスタム設計されたものであると説明している。

|

| 提供:AWS |

Nvidia GPUDirect RDMA技術を採用したElastic Fabric Adapterは、CPUをバイパスしたインスタンス間のハイスループットかつ低レイテンシのGPU間通信を可能にし、MLトレーニングやHPCアプリケーションの分散ワークロードをスケールアウトすることができるとAWSは述べている。

P4dインスタンスは、「4,000以上」のGPUにスケールできるEC2 UltraClustersを構成し、S3やAmazon FSx for Lustre、AWS ParallelClusterなどのAWSサービスに接続することが可能だ。

「これらのクラスタは、自然言語処理、物体検出と分類、シーン理解、地震分析、天気予報、財務モデリングなど、最も過酷なスーパーコンピュータ規模の機械学習とHPCのワークロードにも対応できます」とBarrはブログ記事で述べている。

利用事例は医療から自動車、高度な分析まで多岐にわたっており、GE Healthcare、Toyota Research Institute, Inc.(TRI)、OmniSci、Zenotech Ltd.などの顧客リストに反映されている。

「TRIでは、誰もが自由に動けるような未来の構築に取り組んでいます」と、TRIのインフラストラクチャ・エンジニアリング担当テクニカル・リード、Mike Garrisonは述べている。「前世代のP3インスタンスは、機械学習モデルのトレーニングに要する時間を数日から数時間に短縮してくれましたが、GPUメモリの追加とより効率的な浮動小数点演算フォーマットにより、機械学習チームはより複雑なモデルをより高速にトレーニングできるようになるため、P4dインスタンスの活用を楽しみにしています。」

新しいP4インスタンスは現在、p4d.24xlargeの1サイズで提供されている。

|

インスタンスは、米国東部(バージニア州北部) および 米国西部(オレゴン)のリージョン内でアクセスでき、オンデマンド、スポットインスタンス、リザーブ・インスタンス、専用ホスト、またはAWSの節約プランを利用して購入することが可能だ。

オンデマンドの価格は1時間あたり32.77ドルからとなり、3年契約のリザーブ・インスタンスでは1時間あたり11.57ドルまで下がる。

P4のデビューは、Nvidia Tesla M2050 “Fermi” GPGPUを皮切りに、AWSがGPUを搭載したインスタンスを10年間提供してきたことを示すものである。GPUがデータセンターの要求の厳しいワークロードにユビキタスなものになってきたため、新たに提供されることは少なくなってきている。Barrが詳述しているように、「第1世代のCluster GPUインスタンスは2010年後半に発売され、その後、G2(2013年)、P2(2016年)、P3(2017年)、G3(2017年)、P3dn(2018年)、G4(2019年)のインスタンスが続いています。」

AWSは、NvidiaのA100「Ampere」GPUを採用した最新の大手パブリッククラウドベンダーだ。Google CloudはA100 GPUをベースにしたA2ファミリーを7月に発表しており、Ampereの登場から2ヶ月も経っていない。Microsoft Azureは8月にA100を搭載したNDv4インスタンスをプレビューモードで発表した。翌月、Oracle Cloudは、そのベアメタルのA100を燃料とするインスタンスであるGPU4.8の一般提供を発表した。