中国ムーンショットAI社が兆単位のパラメータを持つモデル「Kimi K2」を発表

オリジナル記事「China’s Moonshot AI Releases Trillion Parameter Model Kimi K2」

アリババが支援する北京のスタートアップ、ムーンショットAIは、新しいオープンウェイトの大規模言語モデルをリリースした。Kimi K2」と呼ばれるこのモデルは、1兆個のパラメータを持ち、オープンウェイトモデルとしては最大級のものだ。システムは一度に320億のパラメータをアクティブにし、基礎モデルと命令チューニングバージョンの両方が提供される。

以下は、ムーンショットによるモデルの説明である:

- Kimi-K2-Base: ファウンデーションモデルは、微調整やカスタムソリューションのための完全な制御を望む研究者やビルダーのための強力なスタートモデルである。

- Kimi-K2-Instruct: ドロップイン型の汎用チャットやエージェント体験に最適なポストトレーニングモデル。長い思考を必要としない反射的なモデルである。

つまり、どの関数を呼び出すかを決定し、結果を評価し、新たなプロンプトなしに計画を調整することができる。MoE(Mixture-of-Experts)アーキテクチャーを採用しており、大規模なモデルを多数の小さな「エキスパート」サブネットワークに分割し、それぞれがデータやタスクの特定のセグメントを処理するように訓練されたニューラルネットワーク設計となっている。ゲーティング・レイヤーが各入力を処理するエキスパートを決定するため、常に実行されるのは全パラメーターのごく一部だけで、モデルの実行に必要なトレーニングと推論の計算量は削減される。

|

|

この効率性は大きな節約につながる: Kimi K2の従量課金価格は、入力トークン100万個あたり約0.15ドル、出力トークン100万個あたり約2.5ドルで、ほとんどの前段階モデルよりもはるかに安い。例えばOpenAIのGPT-4.1は、入力トークン100万個あたり2ドル、出力トークン100万個あたり8ドル、AnthropicのClaude Opus 4は15ドルと75ドルである。これらの節約は、1日に数百万トークンを処理するユーザにとっては数千ドルに相当し、Kimiは1兆パラメータ規模であるにもかかわらず、中位レベルのモデルに典型的なコストプロファイルを与えている。

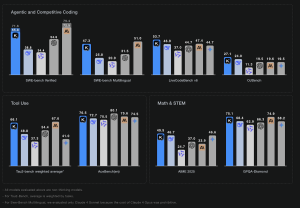

しかし、価格は魅力の一部に過ぎない: 初期のテストによると、Kimi K2は主要なコーディングおよび数学ベンチマークにおいて、主要な独自モデルの性能に匹敵するか、凌駕している。SWE-Benchソフトウェア・エンジニアリング・ベンチマークの人間によって検証されたサブセットであるSWE-Bench Verifiedでは、Kimi K2のスコアは65.8%で、GPT-4.1の54.6%を上回った。このベンチマークには500の実際のGitHubバグ修正タスクが含まれており、AIモデルはすべてのユニットテストに合格するパッチを生成することで解決しなければならない。Kimi K2の65.8%のスコアは、これらの問題のほぼ3分の2を自動的に修復したことを意味する。エンド・ツー・エンドのコーディング・ベンチマークであるLiveCodeBenchでは、Kimi K2は53.7%に達したのに対し、GPT-4.1は44.7%だった。数学推論(MATH-500)では97.4%を記録し、GPT-4.1の92.4%をわずかに上回った。

|

| この図は、Kimi K2のベンチマーク性能のスナップショットである。(出典:ムーンショットAI) |

ムーンショットAIは、Kimi K2の1兆パラメータのトレーニング実行を完全に安定させたのは、同社の新しいMuonClipオプティマイザーのおかげだと評価している。大規模な変換モデルは、しばしば注目レイヤーの「ロジット爆発」に悩まされ、ジョブをクラッシュさせたり、コストのかかる再起動を強いられたりする。MuonClipはこの問題を根本から解決する: 更新のたびに、クエリー行列とキー重み行列を再スケーリングし、生の注目値を安全な数値範囲に保ち、トレーニング中に多くの大規模モデルを脱線させる暴走を防ぐ。

「我々の実験は、MuonClipがダウンストリームタスクのパフォーマンスを維持しながら、ロジット爆発を効果的に防止することを示しています。実際に、MuonClipを使用してK2を15.5Tトークンで事前トレーニングしたところ、トレーニングスパイクはゼロになり、MuonClipが安定した大規模LLMトレーニングのための堅牢なソリューションであることが実証されました」と同社は述べている。トレーニングのクラッシュを防ぎ、計算の無駄を省くことで、MuonClipは研究者がチェックポイントを共有し、同じ土俵でトレーニング方法を比較することを可能にする。

Kimi K2の発売は、ワシントンが先端チップの輸出規制を強化する一方で、北京が国内企業に対して米国のライバル企業との差を縮めるよう促している中で行われた。ムーンショットとディープシークのような同業他社は、この1兆パラメータモデルの重みを公開することで、ローカルハードウェアの制約を緩和しつつ、グローバルな開発者の信頼を築くことを目指している。米国企業は逆の動きを見せている: OpenAIとAnthropicは、安全上の懸念から最新のウェイトを控えており、MetaのLlamaラインが欧米の主要なオープンモデルとして規模を拡大している。

清華大学を卒業したヤン・ジーリンによって2023年に設立されたムーンショットは、当時非常に長い入力を処理するチャットボットで注目を集めた。Kimi K2は、より強力なコーディング・スキルと最大128,000トークンのコンテキスト・ウィンドウを備え、その成果を拡張している。ムーンショットは、ウェブやモバイル製品、APIを通じてKimi K2へのアクセスを提供している。

ムーンショットは、このモデルにはいくつかの限界があると指摘した: 「我々の内部テストでは、現在のKimi K2モデルにはいくつかの限界があることを確認しています。難しい推論タスクや不明確なツール定義を扱う場合、モデルは過剰なトークンを生成し、時には切り詰められた出力や不完全なツール呼び出しにつながることがあります。さらに、ツールの使用を有効にすると、特定のタスクでパフォーマンスが低下することがあります。完全なソフトウェアプロジェクトを構築する場合、ワンショットプロンプトは、エージェントフレームワークの下でK2を使用する場合と比較して、パフォーマンスの低下を引き起こします。今後のリリースでこれらの問題に対処するよう取り組んでおり、より多くのフィードバックをお待ちしています」と同社は記している。Kimi K2の技術的側面についての詳細とデモは、こちらのリンクから。このモデルを無料で試すことができる。

|

|

兆パラメータスケールのオープンウエイトモデルは、私的な実験から共有の科学インフラへの転換点となる。これは、トリリオン・パラメーター・コンソーシアムの目的と一致する。この組織は、オープンなコミュニティを構築し、有望なアイデアを特定してインキュベートし、その成長を促進し、専門知識とリソースのグローバルネットワークを構築することを目的としている。

7月29日から31日まで開催されたTPC25は、トリリオン・パラメーター・コンソーシアムの2025年会議および展示会であり、産業界、学界、国立研究所、ベンダー・コミュニティ、資金調達機関、VCからAIリーダーを招集し、AIを科学的発見やエンジニアリングに大規模に活用するためのベストプラクティスを開発する。会議の詳細と参加方法については、TPC25.orgを参照されたい。

原文は姉妹サイトAIwire.netに掲載された。