AMDの馬力満載GPU「MI300X」がエヌビディアの次期「H200」を上回る

Agam Shah オリジナル記事「AMD’s Horsepower-packed MI300X GPU Beats Nvidia’s Upcoming H200」

AMDとエヌビディアは、両社が何十年にもわたって繰り広げてきたゲーム用GPUの性能競争と同じように、AIの性能争いを繰り広げている。

AMDは、その新しいInstinct MI300X GPUが、エヌビディアの最もホットなH100 GPUと次期H200 GPUを凌ぐ、世界最速のAIチップであると主張している。

AMDのリサ・スー最高経営責任者(CEO)は、今週開催された同社のAIイベントの壇上でスピーチを行い、「これは生成AI向けのアクセラレーターとしては世界最高性能です」と述べた。

このイベントは、ローレンス・リバモア国立研究所で建設中のコードネーム「El Capitan」と呼ばれる2エクサフロップのスーパーコンピューターに搭載されるMI300Aの強化版であるMI300Xの正式発表となった。

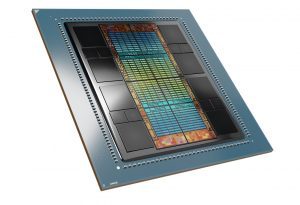

MI300XはCDNA3アーキテクチャで構築されており、FP16やBFLoat16のような主要なAIデータ型に対して3倍以上の性能を発揮する。このチップには1,530億個のトランジスタが搭載され、3Dパッケージで構築されている。このチップは、5ナノメートルと6ナノメートルのプロセスで製造されたチップモジュールを組み合わせている。

チップには304基のGPUコンピュートユニット、192GBのHBM3メモリ、5.3TB/秒のメモリ帯域幅がある。

MI300Xは、ピークFP32性能で163.4テラフロップス、ピークFP64性能で81.7テラフロップスを実現する。

前世代のMI250Xは、単精度(FP32)ベクトルおよび倍精度(FP64)ベクトルのピーク性能で47.9テラフロップスを実現している。AMDはまた、自社のチップをH100のSXMバージョンと比較したが、NVLinkテクノロジーを搭載したH100 NVLモデルは性能差を縮めた。

エヌビディアH100 SXMは、ピークFP32で68テラフロップス、FP64で34テラフロップスの性能を発揮する。しかし、H100 NVLモデルはその差を縮め、FP32性能で134テラフロップス、FP64性能で68テラフロップスを実現したのだ。

エヌビディアの次期H200は、H100のメモリ・アップグレードだが、それでもMI300Xよりもメモリと帯域幅が小さい。H200のGPUメモリは141GBで、帯域幅は4.8TB/秒である。

「MI300Xを見れば、我々はより柔軟性を高め、より多くのメモリ容量と帯域幅を追加することを非常に意識的に決定しました。MI300Xは、競合製品に比べ、メモリ容量が2.4倍、メモリ帯域幅が1.6倍となっています。」

この場合、スー氏はMI300XをエヌビディアのH100 SXMモデルと比較している。H100 SXMモデルは80GBのHBMメモリーを搭載し、メモリー帯域幅は3.35TB/秒である。2枚構成のH100 NVLモデルは、188GBのHBM3メモリを搭載しているが、メモリ帯域幅は7.8TB/秒でMI300Xを上回っている。

AMDがいつまでこのタイトルを保持するかはまだわからない。エヌビディアはチップのアップグレードを毎年計画しており、新GPU「B100」は来年、「X100」は2025年に登場する。

AMDはわずか1年で長い道のりを歩んできた。1年前、AMDはChatGPTの登場で不意を突かれた。チャットボットはエヌビディアを1兆ドル企業へと成長させ、A100とH100 GPUは最もホットな技術資産となった。

GPT-4の背後にあるエヌビディアのハードウェアは、単独でAIの普及を促進し、議論の余地のないAIチャンピオンであり続けている。しかし、エヌビディアのハードウェア不足により、顧客は代替品を探しており、AMDが最新のGPUとシステムを実行可能な代替品として提示する機会を得た。

エヌビディア以外にも、市場にはAMDにとって多くのチャンスがある。

「データセンター・アクセラレーターのTAMは、今後4年間で毎年70%以上の成長を遂げ、2027年には4000億ドルを超えると予想されています。」とスー氏は述べた。

MI300Xチップのトランジスタ数は1,530億個で、5ナノメートルと6ナノメートルのチップレットを12個搭載している。

|

|

| MI300Xは304個のGPUコンピュートユニット、192GBのHBM3メモリ、5.3TB/秒のメモリ帯域幅を持ち、ピークFP32で163.4テラフロップス、ピークFP64で81.7テラフロップスの性能を発揮する。 | |

「世界で最も先進的なパッケージングを採用しています。実際に私たちがどのように組み上げたかを見てみると、かなり驚くべきものです」とスー氏は語った。 MI300Xは、ベースレイヤーに4つのIOダイを搭載している。各IOダイは256メガバイトのInfinityキャッシュと、128チャンネルのHBM3インターフェイス、PCIe Gen5のサポート、複数のMI300Xを接続する第4世代のInfinityファブリックなどの次世代IOを備えている。

このチップは、IOダイの上に8個のCDNA3アクセラレータ・チップレットを積み重ねている。304個のコンピュートユニットは、高密度のシリコン貫通ビア(TSV)を介して接続されている。これにより、毎秒最大17テラバイトの帯域幅がサポートされる。チップは8スタックのHBM3を接続し、合計192ギガバイトのメモリと5.3TB/秒の帯域幅を実現する。

クラウドプロバイダーのマイクロソフト、オラクル、メタは、クラウドインフラにMI300X GPUを搭載しているが、これらの企業は依然としてエヌビディアのチップからAIパワーを生成している。

Amazonは、新しくリリースされたTrainium2チップやインテルのGaudiプロセッサーなど、さまざまな選択肢を提供している。しかし、その意図は明確だ。顧客は選択肢が増え、エヌビディアのH100チップの高値に屈する必要がなくなる。

マイクロソフトの最高技術責任者(CTO)であるケビン・スコット氏は、AMDのイベントの壇上で、「MI300XでGPT-4が登場し、Llamaのパフォーマンスが確認され、本番環境に投入されるのを見るのは……とてもエキサイティングなことです」と語った。

オラクル・クラウドもまた、MI300Xを自社のクラウド・サービスに投入している。また、MosaicMLというAIサービス会社を最近13億ドルでDatabricks社に買収されたナヴィーン・ラオ(Naveen Rao)氏のようなアーリーアダプターとも協力している。

HPCwireで報じられたように、新しいクラウドサービス会社TensorWaveは、スケーラブルで適応性の高い新しいGPUアーキテクチャを2024年に導入する。GigaIO FabreXコンポーザブルPCIe技術に基づくTensorNODEシステムは、最大5,760台のInstinct MI300X GPUをサポートし、すべてのGPUに単一のFabreXメモリ・ファブリック・ドメインを提供する。

AMDもエヌビディアに続き、Infinity Fabricで相互接続された8基のMI300X GPUを搭載するOpen Compute Project準拠のサーバーデザインを発表し、独自のサーバー・アーキテクチャを発表した。このボードは、顧客がサーバーを構築できるOCP準拠のオープン・ブループリントにドロップインされる。

「私たちがこのようにしたのは、非常に慎重な理由からです。マザーボードを取り外してMI300X Instinctプラットフォームを入れることができるのです」とスー氏は語った。

このようなシステムは安価に構築できるため、顧客は最適な価格で柔軟にハードウェアを入手することができる。エヌビディアのHGXシステムは独自のアーキテクチャに基づいており、割高な価格となっている。

MI300XをOCPに準拠させるというAMDの計画は、メタ社が記録的な速さでこのGPUを搭載したサーバーを導入しており、すでに成果を上げている。

「(MI300Xは)OCPモジュール、標準、プラットフォームを活用しているため、記録的な速さで導入することができました。実際、MI300Xはメタ社の歴史の中で最も早く導入されたソリューションのひとつです」と、メタ社のエンジニアリング担当シニア・ディレクター、アジット・マシューズ氏は壇上で語った。

AMDのハードウェア重視は、同社のAIソフトウェア戦略を妨害し、CUDA開発者フレームワークを提供するエヌビディアに遅れをとってきた。CUDAのサポートは、AIを使用する企業におけるエヌビディアのGPU採用を後押ししている。

同社は間もなく次世代GPU「ROCm 6」をリリースする予定で、新機能とパフォーマンスの向上を謳っている。開発者のジョージ・ホッツ氏は、AMDのGPUにはソフトウェアサポート、ドキュメント、開発者へのサポート対応が欠けていると批判したことで有名だ。

AMDのビクター・ペン社長は、「ROCm 6は、MI300Xによって、前世代のリリースに比べて8倍の性能を実現する。

「現在、62,000のモデルがInstinctで動作しており、MI300で動作するモデルも間もなく増えるだろう」とペン社長は述べた。

ROCm 6は、700億個のパラメータを持つ大規模な言語モデルに対して、MI300XはROCm 5のMI250より8倍高速である。ROCm 6フレームワークは、FP16を含む新しいデータタイプをサポートし、パフォーマンスを向上させ、メモリリソースと帯域幅を開放する。また、このフレームワークには、AI性能向上のための多くの低レベル最適化が施される。