インテル、XPU戦略の一環として「インフラストラクチャ・プロセッシング・ユニット」を発表

Todd R. Weiss

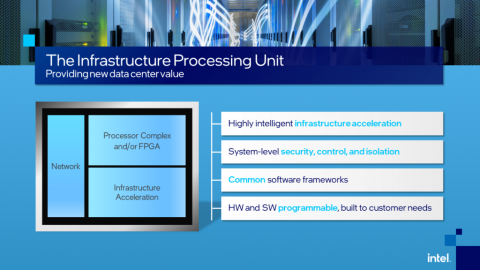

インテル コーポレーションは、クラウド・サービス・プロバイダがホストする多忙なCPUのパフォーマンスを向上させるために、インフラストラクチャ・プロセッシング・ユニット(IPU)の新製品を発表した。IPUは、CPUのオーバーヘッドの一部を引き継ぎ、収益を生み出すタスクに、より多くの処理をさせることができる。

IPUは、GPUがグラフィックス処理の必要性からCPUを解放するように、CPUの処理を軽減するために設計・構築されたプログラマブル・ネットワーキング・デバイスであるとインテルは説明している。

同社によると、ハイパースケールの顧客がCPUのオーバーヘッドを軽減するために開発された新しいFPGAベースのIPUプラットフォームの最初の製品はすでに出荷されており、複数のクラウドサービスプロバイダーに採用されている。また、ASICベースのIPUデザインは現在も開発・テスト中だ。IPUを採用した初期の顧客には、Microsoft、Baidu、JD.com、VMwareなどがある。

このIPUは、6月14日(月)、Futurum Research社とMoor Insights & Strategy社が6月18日まで開催しているSix Five Summitでインテルが発表した。

|

|

| インテルのGuido Appenzeller | |

新しいハードウェアを説明するインテルのビデオの中で、同社のデータプラットフォームグループの最高技術責任者であるGuido Appenzellerは、このデバイスは、大規模なクラウドサービスプロバイダーにとって、クラウドのインフラ機能を実行できるインフラ専用プロセッサであると述べている。

クラウドサービスプロバイダーのソフトウェアはIPU上で動作し、収益を生み出す顧客のソフトウェアはCPU上で動作するという。

「つまり、CPU上で動作する銀行の金融アプリケーションと、IPU上で動作するクラウドサービス事業者のインフラが、きれいに分離されることになります。」とAppenzellerは述べている。クラウド事業者にとってのメリットは、IPUに内蔵されたアクセラレータがこれらの改善を効率的に処理できることだという。

「これによりパフォーマンスが最適化され、クラウド事業者はCPUの100%をゲストに貸すことができるようになり、収益の最大化にもつながります」 と語った。さらにIPUは、ゲストがCPUを完全にコントロールすることができ、必要に応じて独自のハイパーバイザーを追加することもできる。

「しかし、クラウドは依然としてインフラを完全にコントロールしており、ネットワーク、セキュリティ、ストレージなどの機能をサンドボックス化することができるのです。」とAppenzellerは述べている。「また、IPUは、サーバに直接接続されたローカルディスクストレージを、ネットワーク経由で接続された仮想ストレージに置き換えることができます。これにより、データセンターのアーキテクチャが大幅に簡素化されるとともに、非常に大きな柔軟性がもたらされます。」

インテルのIPUは、データセンターの効率性と管理性を向上させるもので、ハイパースケールクラウドのパートナーと共同で構築された唯一の製品だ。

新しいIPUは、インテルのSmartNICの機能を拡張し、現代のデータセンターにおける複雑さや非効率性の軽減に貢献するとのことだ。この新しいIPUは、インテルのクラウド戦略の戦略的な柱の一つとして位置づけられている。

|

インテルによると、GoogleやFacebookの調査では、CPUサイクルの22%から80%がマイクロサービスの通信オーバーヘッドで消費されることがわかっており、これはIPUが対象としている問題の一つである。

今後、FPGAベースのIPUプラットフォームの追加モデルの発売が予定されている。

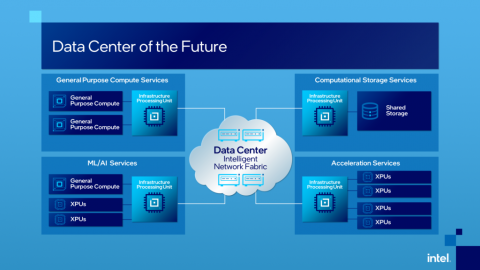

インテルは、進化するデータセンターについて、「大規模な分散型ヘテロジニアス・コンピュート・システムが連携し、シームレスに接続されて単一のコンピュート・プラットフォームとして表示されるインテリジェント・アーキテクチャ」と呼んでいると発表した。「この新しいアーキテクチャは、今日の課題であるリソースの枯渇、データフローの混雑、互換性のないプラットフォームのセキュリティを解決するのに役立ちます。このインテリジェント・データセンター・アーキテクチャーは、汎用コンピュートのCPU、アプリケーションやワークロードに特化したアクセラレーションのXPU、インフラストラクチャ・アクセラレーションのIPUという3つのカテゴリーのコンピュートを持ち、これらをプログラマブル・ネットワークで接続することで、データセンターのリソースを効率的に活用することができます。」

|

J. Gold Associatesの社長兼主席アナリストであるJack E. Goldは、EnterpriseAIに対し、インテルのIPUの発表は重要なステップであるとしながらも、「IPUは全く新しいコンセプトというよりも、おそらく名前を変えたものです。」と述べている。

IPUは、特定の計算をCPUから分離することで、CPUの負担を軽減し、より高速な計算ができるようにするものだとGoldは語る。「IPUは、ストレージネットワークやネットワーク接続など、CPUの負担を軽減するためのものです。これらの機能は、通常であればCPUサイクルのかなりの部分を占めるため、それをCPUの外で行うことができるということは、CPUが接続やデータの移動を管理する代わりに計算を行うことができるということです。」

|

|

| アナリスト Jack Gold | |

これは、仮想化されたストレージ機能、さらにはネットワーク機能仮想化などのサービスに加えて、あまりにも多くのクラウドベースのトラフィックが関与している場合に特に当てはまるとGoldは述べている。

「機能はインテルSmartNIC機能の基本に基づいて構築されているため、全く新しい製品カテゴリーというよりも、むしろ強化されたものと言えます。」と述べている。「また、FPGAを使用しているため、データ移動機能に必要なアクセラレータを事前に設定して最適化することが比較的容易であり、計算集約型の機能はCPUに任せることができます。」

「この分野では競合があります。」とGoldは言う。

「もちろん、Nvidiaのような他社もCPU外の最適化コンポーネントを開発しており、CPUの負荷を軽減しようとしているのはインテルだけではありません。」とGoldは述べている。「しかし、全体的に見れば、この種の製品はコスト面でも性能面でも大きなメリットがあります。」